Nicola Tesla « Trinity a Tierra

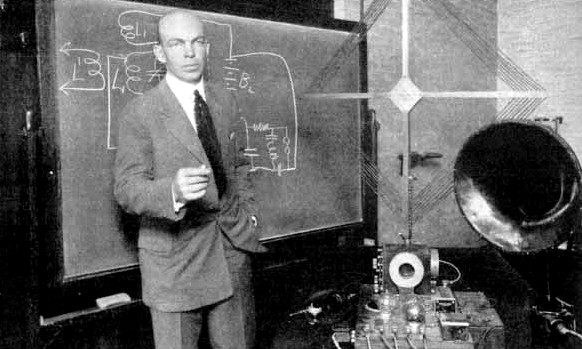

Peter Lindemann, DSc, se interesó en la energía libre en 1973, tras

serle presentado el trabajo de Edwin Gray. Antes de 1981 había

desarrollado sus propios sistemas de energía libre basados en los

generadores de reluctancia variable y en los diseños del motor pulsante.

Durante los años 80 trabajó con Bruce DePalma y Eric Dollard. Desde 1988

hasta 1999 fue miembro de la junta de la Borderland Sciences Research

Foundation. Durante este período publicó como autor más de 20 artículos

para The Journal of Borderland Research. El Dr. Lindemann es una

eminente autoridad en los usos prácticos de la tecnología del éter y de

la electricidad fría.

Actualmente es un asociado de la investigación del Dr. Roberto Adams en

Nueva Zelanda, y colabora estrechamente con Trevor James Constable en

EE.UU. También es director de investigación para Clear Tech, Inc. en

EE.UU. El libro del Dr. Lindemann, The Free Energy Secrets of Cold

Electricity, se repasa en esta edición.

Introducción

Un sondeo efectuado entre los alumnos de primer ciclo del INSA de Lyon

arrojó resultados sorprendentes: de las 87 respuestas recibidas, unos 4

estudiantes eran capaces de aportar informaciones relativas a Nikola

Tesla, lo que representa un 5 % de los estudiantes encuestados. Es muy

poco teniendo en cuenta en entorno científico en el que se realizó el

estudio.Es tanto más sorprendente en cuanto que Tesla dedicó su vida a

la ciencia, permaneciendo soltero toda su vida para consagrarse

plenamente a su pasión: la invención.

En el curso de su vida, inventó numerosas máquinas, algunas de las

cuales son revolucionarias, capaces de conmocionar al mundo entero.

Nadie ha oído hablar nunca de ello.Este es el motivo por el que hemos

decidido escoger este tema para nuestra exposición. Nos ha parecido

primordial para una carrera científica el conocer la existencia de este

hombre notable, así como de su carrera, que estuvo sembrada de

emboscadas.

Estuvo presente en las iniciativas de numerosos progresos en las

ciencias y las técnicas. Muchas de sus creaciones son utilizadas hoy en

día cotidianamente sin que nadie se haga la pregunta de quién fue el

científico que le ha permitido tener esta calidad de vida actual. El

objetivo de nuestra exposición es el de conocer mejor a este genio

desconocido, así como a sus ingeniosos inventos.

Centraremos nuestro dossier en la vida de Tesla y sus inventos, así como

en sus aplicaciones, y no en los aspectos técnicos de todos sus

inventos. Necesitaríamos entonces muchos más tiempo y energía para

comprender los detalles de todas sus invenciones. Todavía hoy los

científicos retoman los trabajos de Tesla. Para todos los inventos

nombrados en este dossier, nos es posible proporcionar una explicación

científica incluso aunque no la incluyamos en el dossier. Queremos

precisarlo ya que es posible que, en un primer momento, se pueda suponer

que estas máquinas contradicen las leyes de la física.

Como conclusión, el debate nos ayudará a reflexionar sobre el

desconocimiento que le envuelve, y la reacción de la sociedad, pública o

científica, frente a los nuevos descubrimientos e invenciones.

Carta de identidad de Nikola Tesla

Nikola Tesla nació el 10 de julio de 1856 en Smiljan, Croacia, cerca de

la costa del Adriático, muriendo el 7 de enero de 1943. Su padre era un

eclesiástico serbio ortodoxo y su madre era una mujer inteligente aunque

analfabeta. Nikola es el penúltimo de una familia de cinco hijos. Sus

padres querían que ingresase en la Iglesia o el ejércitoPosee numerosas

cualidades intelectuales, tales como una gran memoria fotográfica, un

genio inventivo, el don de visualizar con tal nitidez que no tiene

necesidad de maquetas, ni de dibujos, ni siquiera de experimentar. Su

representación mental convierte a los modelos en perfectamente reales.

Además él mismo dice: ” todo lo que invento funciona como lo he

imaginado, la experimentación se desarrolla tal como estaba previsto “.

Desde pequeño inventa objetos originales. Tiene una infancia

problemática debido a una historia familiar muy intensa que le creó

problemas psicológicos y fobias. Es sólo a la edad de 17 años cuando

empieza a interesarse realmente en sus inventos. Tesla aparece como un

autodidacta.

Condecoraciones de Tesla

Recibió en vida numerosas distinciones académicas de universidades americanas y de otros países:

* la medalla John Scott

* la medalla Edison, considerada como el mayor reconocimiento en el terreno eléctrico.

* Numerosos premios otorgados por los gobiernos europeos.Pero no será

hasta 1975 que su nombre entrará a formar parte del panteón de

inventores americanos.

Parte 1: La electricidad

Sus inicios en la escuela

En 1875 ingresa en la escuela politécnica de Graz en Austria, donde

estudia matemáticas, física y mecánica.Su profesor de física le presenta

un aparato de corriente continua que funciona a la vez como un motor y

como una dínamo. El inconveniente es que esta máquina produce muchas

chispas. Tesla la examina y propone reemplazar la corriente continua por

corriente alterna, lo que según el profesor llevaría a obtener el

movimiento perpetuo, es decir, un imposible.La idea de transformar esta

máquina no lo abandonará: “para mí es un voto sagrado, una cuestión de

vida o muerte. Sé que moriré si fracaso. En el fondo de mi cerebro se

encuentra la solución pero todavía no consigo expresarla”.

Invención del motor de corriente alterna

Seis años más tarde, en una conferencia en el Instituto Americano de

Ingenieros Eléctricos, revela un nuevo principio científico de su

simplicidad deslumbradora. Sus aplicaciones prácticas revolucionarán el

mundo tecnológico. Tesla acaba de descubrir un nuevo sistema, el

principio del campo magnético rotativo, generado por corrientes alternas

en número de una o más desfasadas las unas en relación a las otras.

Acababa de inventarse el motor de corriente alterna.

Lucha por la investigación de un estándar eléctrico

En los meses posteriores a esta conferencia, se aplica totalmente al

objetivo de inventar nuevas formas de máquinas de corriente alterna.En

1883 consigue construir su verdadero primer motor de inducción de

corriente alterna. Incapaz de lograr interesar a nadie en Europa con su

radical procedimiento, Tesla aceptó el ofrecimiento de Thomas Edison,

que le proponía ir a trabajar a Estados Unidos. Al año siguiente, con 28

años, decide embarcarse y probar suerte para trabajar con Edison en

Estados Unidos, donde este último acaba de crear la red eléctrica que

suministra a la ciudad de Nueva York.Esta red, basada en la corriente

continua, sufre importantes malfuncionamientos: frecuentes accidentes,

averías regulares, varios incendios causados por la electricidad…

Además, la corriente no puede ser conducida a larga distancia (hasta dos

millas) ya que las líneas no podrían soportar tensiones elevadas,

indispensables para transmisiones alejadas. Es necesaria una central

cada dos millas.

Tesla interviene entonces hablando de su motor de inducción de corriente

alterna, que según él es la tendencia del futuro: “Quién desarrolle

esta técnica, se hará rico”. Edison no está de acuerdo. Envía a Tesla

para reparar la instalación eléctrica de un vapor, lo que realiza

rápidamente. Descubre la manera de mejorar las primitivas dínamos de

Edison, y le ofrecen 50.000 dólares para proseguir su trabajo.

A Edison no le gusta el genio de Tesla, se siente amenazado por sus talentosas invenciones.

El problema entre los dos hombres se agrava, lo que obliga a Tesla a

dimitir.Un grupo de financieros, conscientes del potencial económico,

propone a Tesla que funde una sociedad, lo que él hace. Desgraciadamente

se los pone en contra y se encuentra sin dinero, ya que los financieros

recuperan su empresa, en la que había invertido sus ahorros.Un

dirigente de una gran sociedad, Westinghouse, se interesa de inmediato

en su corriente alterna. En 1886 se asiste a la primera inauguración

comercial del sistema de corriente alterna. Su motor de inducción es

rápidamente reconocido como un elemento de nueva tecnología.

Westinghouse, el rival directo de Edison, sueña con abastecer a Estados

Unidos con la corriente alterna, y firma un contrato con Tesla, en

calidad de consultor. Se inicia una lucha titánica entre

Westinghouse-Tesla y Edison, que se decanta a favor de

Westinghouse-Tesla.

Instalación de la corriente alterna en Estados Unidos

En enero de 1893 Westinghouse anuncia que su empresa acaba de obtener el

contrato de instalación de toda la infraestructura eléctrica. Pronto se

utilizará exclusivamente la corriente alterna de Tesla, el sistema tan

encarnecido y calumniado. Toda la electricidad utilizada en el mundo en

aquella época será producida, transmitida, distribuida y transformada

por medio del sistema polifásico de Tesla. La transmisión de la

corriente durante centenares o miles de kilómetros ya no será un

problema.Las dos primeras fábricas generadoras de corriente sobre el

Niágara se construyen a partir de octubre de 1893, una de las cuales

directamente sobre las cataratas del Niágara. La primera quedará

concluida en 1896, y alimentará a Buffalo.

En Nueva York los tranvías y los metros funcionan con corriente alterna,

y la electrificación de las vías de tren está en camino.La industria

metalúrgica también necesita altas tensiones que sólo la alterna puede

proporcionar, se asistente entonces a un desarrollo fulgurante de la

aeronáutica. La electricidad permite disponer de una gran energía

mecánica, calorífica, electromagnética, lo que conducirá a una

extraordinaria revolución para la industria.

En 1906 Tesla inventa una turbina: 4,5 Kg. y 30 caballos de vapor. Tesla

piensa que podría rebajar el coste de la electricidad dado su bajo

coste de fabricación en relación a lo que se hace en aquella época.

Parte 2: La luz

Lámpara de pastilla de carbono – luz de alta frecuencia

El punto fuerte de sus demostraciones en este campo es la lámpara de

pastilla de carbono, presentada en 1891. Está formada por un tubo al

vacío (pero que contiene algunos iones en estado gaseoso) de 15 cm.

Acabada por un pequeño globo de cristal dotado de una pieza minúscula de

material sólido, montada en el extremo de un hilo de conexión única con

la fuente de alta frecuencia. La pastilla central del material propulsa

electrostáticamente las moléculas del gas que la rodea hacia el globo

de cristal, luego las atrae de la misma manera, al ritmo de la fuente de

alta frecuencia. Al golpear la pastilla a su regreso, las moléculas la

calientan hasta la incandescencia, en un proceso que se repite millones

de veces por segundo.

El calor de la pastilla incandescente se transfiere a las moléculas de

la pequeña cantidad de gas del tubo, y así se produce la luz.Esta

bombilla es muy barata, y con el mismo gasto energético, es 20 veces más

brillante que la bombilla de Edison, la que utilizamos en la

actualidad. El único problema es que se necesita una fuente de corriente

de alta frecuente, lo que desgraciadamente no es compatible con los 50

Hz tradicionales.

El tubo de neón se inspira en los descubrimientos de Tesla, pero su rendimiento no es tan interesante.

Microscopio electrónico

La lámpara con pastilla de carbono también contiene el concepto del

microscopio electrónico. Se generan partículas que son enviadas en línea

recta a partir de un minúsculo punto de actividad sobre la pastilla,

mantenida a un potencial elevado. Con la corriente continua sólo se

consigue expulsar las partículas. En la superficie del globo, las

partículas reproducen con una imagen fosforescente el dibujo del punto

microscópico desde el que son emitidas.Inspirándose en esta constatación

hecha por Tesla, los científicos descubren en 1939 la posibilidad de

utilizar un microscopio no ya con luz, sino que gracias a un flujo de

electrones da una resolución mucho más grande. La descripción de Tesla

del efecto obtenido con su lámpara de pastilla de carbono se encuentra

casi sin cambios en los términos para describir al microscopio

electrónico.

Acelerador de partículas

La lámpara de partículas contiene también ciertos aspectos de los

aceleradores de partículas. En efecto, la expulsión de partículas de

alta velocidad en los aceleradores lineales se encuentra en la lámpara.

Además, el fenómeno de resonancia (ver parte mecánica) interviene en los

aceleradores de tipo ciclotrón.

Parte 3: La mecánica

Invención de un avión de despegue y aterrizaje vertical

Fue en 1928, a sus 72 años, cuando Tesla construyó un modelo de avión de

despegue y aterrizaje vertical. El modelo de Tesla es un primer paso

innegable en la búsqueda en este terreno. Es notable que hubiera tenido

esa idea en una época en la que la aviación estaba en mantillas. Los

planos de Tesla han sido posteriormente utilizados en las

investigaciones americanas para el desarrollo de sus aviones. En 1980

todavía impactaba la posibilidad de construir aviones con esta

especificidad.

Las oscilaciones mecánicas y las vibraciones armónicas: la resonancia

En 1898 prueba un oscilador minúsculo que acopla a un pilar de hierro

fundido que atraviesa un inmueble. Se produce una vibración en todo el

inmueble y el pánico de todos los inquilinos que creen que se trata de

un terremoto. Tesla acaba de demostrar el efecto de la resonancia ” esta

viga no hubiera podido ser destruida con mazas, ni incluso con

palancas: ha bastado una ráfaga de pequeños golpes que, por separado, no

hubieran podido lastimar ni a una mosca “. Es posible que un alfeñique

impulse a una persona corpulenta en un balancín, si le empuja siempre en

el momento preciso para permitir una amplificación del movimiento.

Este fenómeno también tiene aplicaciones en electricidad.

Parte 4: La energía libre

Introducción

Fue en el transcurso de la conferencia del 20 de mayo de 1891 en el

Instituto Americano de Ingenieros Eléctricos de Nueva York, que Testa

habló por primera vez de energía libre. He aquí lo que dijo:” Dentro de

algunas generaciones, nuestras máquinas serán propulsadas por esta

energía disponible en cualquier parte del universo (…) En el espacio

existe una forma de energía ¿Es estática o cinética? Si es estática,

todas nuestras investigaciones habrán sido en vano.

Si es cinética -y sabemos que lo es – es tan sólo cuestión de tiempo, y

la humanidad pondrá en armonía sus técnicas energéticas con los grandes

engranajes de la naturaleza “El 30 setiembre de 1894 Tesla publica un

artículo en el que expone su teoría de la luz, la materia, el éter y el

universo, y afirma que el 90% de la energía de las luces eléctricas es

malgastado: ” espero vivir lo suficiente para ser capaz de colocar una

máquina en el centro de esta habitación, y hacerla funcionar únicamente

con la energía del entorno “.

Noción de éter y de energía del campo del vacío

El concepto de éter fue introducido por Aristóteles para designar al

quinto elemento. Este término englobaba en su origen a todos los objetos

que se encontraban en el exterior de la atmósfera terrestre. Los

físicos de la Edad Media postulaban que el éter es una sustancia que

llena el espacio. Newton también se refirió al mismo. Posteriormente,

Maxwell pensaba que ” no hay duda de que los espacios interplanetarios e

interestelares no están vacíos, sino llenos de una sustancia que existe

en grandes cantidades y es regular “.Se realizaron experiencias para

intentar demostrar la existencia del éter.

Un experimento se hizo famoso. Si el éter existía, debían existir

“vientos de éter” debidos a la rotación de la tierra, suponían los

físicos de la época. Se enviaron dos señales: una contracorriente de los

vientos del éter, y la otra en la misma dirección. Los científicos

esperaban una separación entre los tiempos empleados por las dos señales

en recorrer una misma distancia. El experimento no reveló diferencia

alguna. Debido a ello se produjo un rechazo del concepto de éter. Pero

muchos científicos piensan todavía que el concepto de éter no es una

ficción. Por lo demás, he aquí la lista de científicos que postulan la

existencia de este elemento, por nombrar sólo a los más conocidos:

• Paul Dirac (Premio Nobel, 1933)

• De Broglie (Premio Nobel,1929)

• A. Michelson (Premio Nobel,1907)

• A. Einstein (Premio Nobel,1921)

• Sir Oliver Lodge

• Muchos otros Premios Nobel

De este éter se puede sacar energía. El espacio presente entre los

átomos no está vacío, sino lleno de energía. Su concentración es

altamente elevada, del orden de los 5.000 Kwh. por cm3 según algunos

cálculos. Es difícilmente perceptible, a menos de hacerlo actuar con

campos electromagnéticos o con materia. Sería imposible no tener

energía, ya que es omnipresente. Como analogía, se puede citar este

ejemplo: un hombre sentado en el fondo del mar, con una taza en la mano,

se pregunta como puede llenar su taza de agua.

En esta analogía, el agua hace el papel del éter, y el hombre en el

fondo del mar, el de la Humanidad que vive en la Tierra. La

omnipresencia de esta energía nos hace olvidar que existe y que es

infinita.

Pero el concepto de éter tiende a borrarse del pensamiento de los

grandes físicos de la época. A los 15 años, Albert Einstein (1879-1955)

pensaba como muchos otros científicos, que existía sin duda un éter y

que el espacio no estaba vacío.

Más tarde abandonó esta idea, que continuó rechazando durante muchos

años. Fue en ese momento cuando desarrolló la teoría relativista que se

impuso entre los físicos. Se ignoró todo lo que Einstein dijo más tarde

acerca del éter. En 1934 retomó esta teoría diciendo que el espacio no

podía estar vacío, que el espacio es un medio dinámico.

Las máquinas de energía libre

Tesla es pionero en este terreno. Fue el primero en inventar una máquina

que extraía su energía de una fuente infinita e inagotable, la energía

del punto cero, o más vulgarmente llamada la energía libre. Tesla

inventó una máquina que no solo es capaz de autoalimentarse, sino que

saca la energía del aire que la rodea. Su aparato era una bobina de

electroimanes, para la cual obtuvo una patente en 1894.

La forma de su bobina permitía a un sistema de almacenaje de una enorme

cantidad de energía, utilizando tan solo una parte ínfima de esta

energía para su propio funcionamiento. Se la puede comparar a un

vehículo que tuviese un enorme depósito de gasolina siempre lleno, y que

consumiera sólo dos litros por cada cien kilómetros.En nuestros días se

han construido máquinas de energía libre y funcionan con el aire

ambiente como único carburante. Bruce DePalma es el inventor más

conocido en energía libre, con su máquina-N. En ella utiliza imanes muy

potentes para hacer que la energía del espacio trabaje en la tierra, ya

que considera que ” el imán es una ventana a la energía libre del

espacio “.

También existe otra forma de energía libre: la energía radiante. Tesla

intentó un aparato capaz de captar la energía directamente del sol. Este

procedimiento no es muy ventajoso ya que su rendimiento no es demasiado

alto.

Actualidades y puesta al día

Es muy raro ver en revistas artículos relativos al éter, y todavía menos

a la energía libre, ya que un 95% de personas nunca han oído hablar de

ello. Pero en Sciences et Avenir de enero de 2002, en el dossier « Los

herejes de la ciencia », Jean Pierre Vigier , considerado probablemente

como el mayor físico francés vivo, defiende la idea de un éter material:

« existe un éter material, físico, portador de ondas y partículas,

exactamente igual como el mar es portador de un navío». Luego continúa

evocando sucintamente la idea de una energía infinita: « Extraer energía

del vacío para convertirla en fuente inagotable: viejo sueño o fantasía

».Se realizó un experimento para intentar hacer evidente la fuerza del

vacío: «Construyeron un columpio de 500 micrómetros cuadrados suspendido

a algunos nanómetros del suelo.

Luego se aproxima una esfera a menos de un micrómetro. Incluso sin que

haya contacto, el columpio se inclina». En física cuántica, el vacío no

está realmente vacío, de hecho es la sede de fluctuaciones que crean

partículas virtuales engendrando una fuerza de presión atractiva sobre

las placas.

Las posibles consecuencias

Evidentemente, se pueden encontrar multitud de campos en los que el uso de una energía limpia e infinita sería muy benéfico.

Se puede citar al automóvil, a la calefacción de las habitaciones y en

general a la industria. Sería muy beneficioso utilizarla en el terreno

espacial. « El genio inventor del hombre nos permitirá no sólo viajar

por el universo a una velocidad inimaginable, en una trayectoria fija,

sino que nos permitirá también, gracias a la energía que podrá obtenerse

del espacio, tener autonomía y mantenernos durante largos períodos con

un consumo mínimo de energía »

Estos aparatos de energía infinita podrían otorgar la independencia energética a la población.

Se pueden imaginar construcciones privadas de aparatos, de medidas

variables: desde el generador en el jardín, hasta la central con

potencia suficiente para iluminar toda una ciudad. Algunos científicos

piensan que es el camino a seguir para el futuro. Otros, por el

contrario, piensan que « el hecho de dar a la sociedad una energía

abundante, barata e inofensiva, sería lo peor que podría ocurrir en el

planeta, porque las personas podrían utilizarla con fines no

necesariamente positivos ».Reflexionemos un poco en cuanto a los

beneficios que pueden aportarnos una energía limpia e infinita: todos

los bosques, lagos y océanos dejarían de estar amenazados de ser

contaminados con residuos radioactivos, o por petróleo.

El aire de las ciudades sería más puro, el ruido incesante de los coches

se reduciría. Las industrias emitirían menos productos polucionantes al

aire. En resumen, se llegaría a aumentar la vitalidad de las personas,

ya que respirarían aire puro, beberían agua descontaminada y se

nutrirían con alimentos sanos.

Parte 5: las radiocomunicaciones

Dónde está la energía libre?, ¿Qué fue de la energía libre?

A fines de 1880, las revistas especializadas en ciencias eléctricas

predecían la “electricidad libre” para un futuro cercano. Los increíbles

descubrimientos sobre la naturaleza de la electricidad eran hechos

cotidianos. Nikola Tesla demostraba la “iluminación sin hilos” y otras

maravillas asociadas con las corrientes de alta frecuencia. Existía un

entusiasmo sobre el futuro como nunca antes se había conocido en la

historia.En un plazo de 20 años habría automóviles, aeroplanos,

películas, cámaras fotográficas, música grabada, teléfonos y radio.

La era Victoriana nos llevaba hacia algo completamente nuevo. Por

primera vez en la historia, el pueblo tenía esperanzas de un futuro

utópico, con modernos sistemas de transporte y comunicaciones en

abundancia, así como trabajo, ropa y alimentos para todos. Se

conquistarían la enfermedad y la pobreza. El nivel de vida iría

mejorando a la vez que cada uno tendría su “pedazo del pastel”.

Entonces, ¿qué sucedió? En medio de toda esta explosión tecnológica,

¿dónde se fueron todos los progresos en energía? Todo aquel entusiasmo

sobre la “electricidad libre”, que ocurrió momentos antes del principio

del siglo pasado, ¿fue quizá el optimismo a ultranza que la “ciencia

verdadera” eventualmente ha desacreditado?Realmente, la respuesta a esta

pregunta es “no”. De hecho, la verdad es todo lo contrario. Las

espectaculares tecnologías en energía fueron desarrolladas junto con

otros progresos. Desde aquella época, se han desarrollado múltiples

métodos para producir grandes cantidades de energía a un costo

extremadamente bajo. Sin embargo, ninguna de esas tecnologías han hecho

que se “abra” al mercado de consumo como artículo de comercio. Pronto

discutiremos el por qué de todo esto.

Estado Actual de la Tecnología

Primero, describiré una corta lista de las tecnologías que forman la

“energía libre”, de las que estoy actualmente enterado, y que están

demostradas más allá de toda duda razonable. La característica común que

conecta todos estos descubrimientos es que utilizan una pequeña

cantidad de una forma de energía, para controlar o liberar una gran

cantidad de otra forma de energía. Muchos de ellos, de alguna manera,

cogen ligeramente el campo subyacente del éter, una fuente de energía a

la que la ciencia “moderna” ha ignorado convenientemente.

1. Energía Radiante

El Transmisor Amplificador de Nikola Tesla, el dispositivo de energía

radiante de T. Henry Moray, el motor EMA de Edwin Gray y la máquina

Testatika de Paul Baumann, funcionan todos con la denominada “energía

radiante”. Esta forma natural de energía (erróneamente denominada

“electricidad estática”) se puede extraer directamente del ambiente o de

la electricidad ordinaria, por el método llamado “de fraccionamiento”.

La energía radiante puede realizar las mismas maravillas que la

electricidad ordinaria, por menos del 1% de su coste. Sin embargo, no se

comporta exactamente como la electricidad, y esto ha contribuido a que

fuera malentendida por parte de la comunidad científica.Actualmente, la

Comunidad de Methernitha, en Suiza, tiene en activo cinco o seis modelos

de estos dispositivos, que explotan ligeramente esta energía,

funcionando como dispositivos auto-arrancables (no necesitan energía

para el arranque inicial) y sin combustible.

2. Motores accionados por imán permanente

El Dr. Robert Adams (Nueva Zelanda) ha desarrollado asombrosos diseños

de motores eléctricos, generadores y calentadores, que funcionan en base

a imanes permanentes. ¡Uno de esos dispositivos necesita 100 vatios de

electricidad de unas baterías, genera 100 vatios para recargar las

baterías, y produce además más de 140 BTUs de calor en dos minutos!El

Dr. Tom Bearden (E.E.U.U.) tiene trabajando dos modelos de un

transformador eléctrico, accionado por imán permanente. Utiliza una

entrada eléctrica de 6 vatios para controlar la trayectoria de un campo

magnético que sale de un imán permanente. Canaliza el campo magnético,

primero a una bobina de salida y luego a una segunda bobina de salida.

Repite el proceso rápidamente, de una manera análoga al “ping-pong”.

El dispositivo puede producir una salida eléctrica de 96 vatios, sin

piezas móviles. Bearden llama a su dispositivo Generador

Electromagnético Inmóvil o MEG (Motionless Electromagnetic

Generador).Jean-Louis Naudin ha duplicado el dispositivo de Bearden en

Francia. Los principios para este tipo de dispositivo fueron divulgados

por primera vez por Frank Richardson (E.E.U.U.), en 1978.Troy Reed (

E.E.U.U.) tiene en funcionamiento modelos de un ventilador especialmente

magnetizado, que calienta mientras gira. Toma exactamente la misma

cantidad de energía para hacer girar el ventilador, genere o no

calor.Más allá de todos estos progresos, múltiples inventores han

identificado los mecanismos de trabajo que producen un torque motor

solamente de los imanes permanentes.

3. Calentadores mecánicos

Hay dos clases de máquinas que transforman una pequeña cantidad de

energía mecánica en una gran cantidad de calor. El mejor de estos

diseños, puramente mecánicos, es el sistema de cilindro rotatorio,

diseñado por Frenette (E.E.U.U.) y Perkins (E.E.U.U.).En estas máquinas,

un cilindro rota dentro de otro cilindro, del que le separan unos 3 mm.

El espacio entre los cilindros se llena de líquido, que puede ser agua o

aceite, y es este “líquido de funcionamiento” el que se calienta cuando

se hace girar el cilindro interno.Otro método utiliza imanes montados

en una rueda para producir grandes corrientes de Foucault en una placa

de aluminio, haciendo que esta placa se caliente rápidamente. Estos

calentadores magnéticos han sido demostrados por Muller (Canadá), Adams

(NZ) y Reed (E.E.U.U.).Todos estos sistemas pueden producir 10 veces más

calor que los métodos estándar, usando la misma entrada de energía.

4. Electrólisis súper-eficiente

El agua se puede descomponer en hidrógeno y oxígeno, utilizando electricidad.

Los libros estándares de química dicen que este proceso requiere más

energía de la que se puede recuperar cuando se recombinan los gases.Esto

es cierto únicamente en el peor de los casos. Cuando el agua se excita

con su propia frecuencia resonante molecular, según un sistema

desarrollado primero por Stan Meyer (E.E.U.U.) y recientemente por Xogen

Power, Inc., se colapsa en los gases hidrógeno y oxígeno, con una muy

pequeña entrada eléctrica.También, al usar diversos electrólitos

(añadidos que hacen que el agua conduzca mejor la electricidad) la

eficacia del proceso cambia drásticamente.Se sabe igualmente que ciertas

estructuras geométricas y texturas superficiales son mejores que otras.

La implicación es que se pueden producir cantidades ilimitadas de

combustible hidrógeno para hacer funcionar los motores (como el de un

coche), por el coste del agua.Más sorprendente aún es el hecho de que

Freedman (E.E.U.U.) patentó en 1957 una aleación metálica especial, que

descompone espontáneamente el agua en hidrógeno y oxígeno, sin entrada

eléctrica exterior y sin causar ningún cambio químico en el propio

metal. Esto significa que esta aleación metálica especial puede producir

hidrógeno del agua, libre y de forma indefinida.

5. Motores de implosión/vortex

La mayoría de motores industriales utilizan la liberación de calor para

causar expansión, y presión para producir trabajo, como en el motor de

un coche. La naturaleza utiliza el proceso opuesto de enfriamiento para

originar succión y vacío para producir el trabajo, como lo que ocurre en

un tornado.Entre1930 y 1940, Viktor Schauberger (Austria) fue el

primero en construir modelos funcionales de los motores de implosión.

Desde esa época, Callum Coats ha escrito extensamente sobre los trabajos

de Schauberger en su libro “Living Energy”.

Posteriormente, un gran número de investigadores han construido modelos

operativos de los motores de turbina de implosión. Éstos son motores sin

combustible (fuelles) que producen trabajo mecánico por la energía

alcanzada en un vacío. También hay diseños mucho más simples que

utilizan movimientos del vórtice para explotar una combinación de

gravedad y fuerza centrífuga para producir un movimiento continuo en

líquidos.

6. Tecnología de la fusión fría

En marzo de 1989, dos químicos, Martin Fleischmann y Stanley Pons, de la

Brigham Young University, Utah (USA), anunciaron que habían producido

reacciones atómicas de fusión en una probeta. Los anuncios fueron

“desacreditados” dentro de los seis meses siguientes y el interés

público se perdió.Sin embargo, la fusión fría es real.

El exceso de la producción del calor se ha documentado no sólo en varias

ocasiones, sino que también se ha catalogado la transmutación atómica

de elementos a baja energía, ¡implicando docenas de diversas reacciones!

Esta tecnología puede producir definitivamente energía barata y docenas

de otros procesos industriales importantes.

7. Bombas de calor asistidas por energía solar

El refrigerador de cocina es la única “máquina de energía libre” que

cualquiera puede poseer. Es una bomba de calor que funciona

eléctricamente. Utiliza una cantidad de energía (electricidad) para

mover tres cantidades de energía (calor). Esto le da un “coeficiente del

funcionamiento” (COP) de cerca de tres. El refrigerador utiliza una

cantidad de electricidad para bombear tres cantidades de calor desde el

interior del refrigerador al exterior del mismo. Éste es su uso típico,

pero es la peor manera posible de utilizar la tecnología. Veamos por

qué. Una bomba de calor bombea calor desde la “fuente” del calor hasta el

“sumidero” o lugar que absorbe el calor. La “fuente” de calor debe,

obviamente, ser caliente y, obviamente, para que este proceso trabaje

mejor el “sumidero” debe ser frío. En el refrigerador ocurre exactamente

lo contrario.

La “fuente” de calor está dentro de la caja, que es fría, y el

“sumidero” para el calor es el aire a temperatura ambiente de la cocina,

que es más caliente que la fuente. Esta es la razón por la cual el COP

sigue siendo bajo para el refrigerador de cocina. Pero esto no es verdad

para todas las bombas de calor.Con las bombas de calor, asistidas por

energía solar, se logran fácilmente COPs de 8 a 10.

En tales dispositivos, una bomba de calor extrae calor de un colector

solar, y lo descarga en un absorbedor subterráneo grande, que permanece

aproximadamente a 12.8ºC.; la energía mecánica se extrae en la

transferencia. Este proceso es equivalente al de un motor de vapor que

extrae energía mecánica entre la caldera y el condensador, excepto que

utiliza un líquido que las “hierve” a una temperatura mucho más baja que

el agua.Uno de tales sistemas, probado en los años 70, produjo 350 HP,

medidos en un dinamómetro, en un motor especialmente diseñado con apenas

100 pies cuadrados del colector solar (9,3 m2). (Éste no es el sistema

promovido por Dennis Lee.

La cantidad de energía que tomó para hacer funcionar al compresor

(entrada) era de menos 20 HP, así que este sistema ¡produjo 17 veces más

energía de la que tomó para mantenerse funcionando! Colocado en una

azotea, podría suministrar a un pequeño vecindario, usando exactamente

la misma tecnología que mantiene el alimento frío en su cocina.Hay

actualmente un sistema de bomba de calor a escala industrial, ubicado al

norte de Kona, Hawaii, que genera electricidad a partir de las

diferencias de temperatura del agua del océano.

Docenas de otros sistemas no se han mencionado, y muchos de ellos son

tan viables y probados como los que se ha comentado.Pero esta corta

lista es suficiente para hacer hincapié en un punto: la tecnología de la

energía libre está aquí y ahora. Ofrece al mundo, para todos, y en

todas partes, abundancia de energía sin contaminación.Es posible ahora

detener la producción de los gases que producen el efecto invernadero, y

cerrar todas las plantas de energía atómica. Podemos ahora desalinizar

cantidades ilimitadas de agua de mar, a un precio asequible, y llevar

agua fresca adecuada a los habitats más alejados. Los costes del

transporte y producción para todo pueden caer drásticamente. Incluso los

alimentos se pueden sembrar en invernaderos calentados durante el

invierno, en cualquier lugar.Todas estas ventajas maravillosas, que

pueden hacer la vida en este planeta más fácil y mejor para todos, se

han pospuesto por décadas. ¿Por qué? ¿A quiénes han servido los

propósitos de este aplazamiento?

Enemigos Invisibles de la Tecnología de la Energía Libre

Cuatro gigantescas fuerzas han trabajado juntas para crear esta

situación. Decir que existe y que ha existido una conspiración para

suprimir esta tecnología, conduce solamente a una comprensión

superficial del mundo. Y coloca la responsabilidad totalmente fuera de

nosotros mismos. Nuestra buena voluntad de seguir siendo ignorantes e

inactivos frente a esta situación, ha sido interpretada siempre por dos

de estas fuerzas como consentimiento implícito.

Así pues, además de “un público no exigente”, ¿cuáles son las otras tres

fuerzas que impiden la disponibilidad de la tecnología de la energía

libre?

1. El Monopolio Del Dinero

En la teoría económica estándar, hay tres clases de industria: capital, mercancías y servicios.

Dentro de la primera clase, el capital, también hay tres subclases:

capital natural, efectivo y crédito. El capital natural se relaciona con

las materias primas (tales como una mina de oro) y las fuentes de

energía (tales como un pozo de petróleo o una hidroeléctrica).

El efectivo se relaciona con la impresión del “dinero de papel” y la

acuñación de monedas; de estas funciones generalmente se encarga el

gobierno. El crédito se relaciona con los préstamos de dinero por

interés y la extensión de su valor económico a través del depósito de

cuentas de empréstito. Según esto, es fácil ver que la energía funciona

en economía de la misma manera que el oro, la impresión de dinero por

parte del gobierno, o la aplicación del crédito por un banco.

En Estados Unidos, así como en la mayoría del resto de países del mundo,

existe un monopolio del dinero. Somos libres de ganar tanto dinero como

queramos, pero solamente se nos pagará con billetes de la Reserva

Federal.

No hay nada que se pueda hacer para ser pagado con certificados del oro,

o con alguna otra forma de dinero. Este monopolio del dinero está

solamente en manos de un pequeño número de bancos privados, y estos

bancos son posesión de las familias más ricas del mundo.Su plan es,

eventualmente, controlar el 100 por ciento de todos los recursos de

capital mundial, de tal manera que se pueda controlar la vida de cada

uno con la disponibilidad (o no disponibilidad) de todas las mercancías y

servicios.

Una fuente independiente de riqueza (un dispositivo de energía libre),

en manos de cada persona del mundo, arruinaría permanentemente sus

planes para la dominación del mundo. Es fácil ver por qué esto es

verdad.Actualmente, la economía de una nación puede retrasarse o

acelerarse dependiendo de si suben o bajan los tipos de interés. Pero si

una fuente independiente de capital (energía) estuviera presente dentro

de la economía, y cualquier negocio o persona pudiera generar más

capital, sin pedir un préstamo a un banco, ésta estrangulante acción

centralizada en los tipos de interés simplemente no tendría el mismo

efecto.

La tecnología de la energía libre cambia el valor del dinero. Las

familias más ricas, y los emisores del crédito, no desean ninguna

competición. Es así de simple. Desean mantener su control actual del

monopolio de la fuente de dinero. Para ellos, la tecnología de la

energía libre no debe ser simplemente suprimida, ¡debe ser

permanentemente prohibida!Así pues, las familias más ricas, y sus

instituciones de actividades bancarias centrales, son la primera fuerza

que actúa para posponer la disponibilidad pública de la tecnología de la

energía libre. Sus motivaciones son “el derecho divino de gobernar”; la

avaricia, y la insaciable necesidad de controlarlo todo excepto a sí

mismos.

Las armas para cumplir este aplazamiento incluyen:

• la intimidación,

• los “expertos” desenmascaradores,

• la compra y “encajonado” de la tecnología,

• el asesinato e intento de asesinato de los inventores,

• los incendios maliciosos, y

• una amplia variedad de incentivos y frenos financieros para manipular a los posibles defensores o partidarios.

También han promovido la aceptación general de una teoría científica que

dice que la energía libre es imposible (las leyes de la termodinámica).

2. Gobiernos Nacionales

La segunda fuerza que opera para posponer la disponibilidad pública de

la tecnología de la energía libre son los gobiernos nacionales. El

problema aquí no se relaciona con la competición en la impresión de los

billetes sino con el mantenimiento de la Seguridad Nacional.Existe el

concepto de que el mundo es una selva, y de que los seres humanos han de

ser considerados como extremadamente crueles, deshonestos y engañosos.

Es trabajo del gobierno prever la defensa común. Para esto, las fuerzas

policiales están delegadas por la rama ejecutiva del gobierno para hacer

cumplir la ley. La mayoría de nosotros consentimos la regla de la ley

porque creemos que es lo correcto, que funciona en nuestro propio

beneficio. Sin embargo, siempre hay algunos individuos que creen que su

propio beneficio está mejor servido por comportamientos que no se

conforman voluntariamente con el orden social generalmente convenido.

Esta gente prefiere funcionar fuera de “la ley”, y son considerados

proscritos, criminales, subversivos, traidores, revolucionarios o

terroristas.

La mayoría de los gobiernos nacionales han descubierto, por ensayo y

error, que la única política extranjera que realmente funciona a cierto

plazo es una política de intercambio de “esto por aquello”. Esto

significa que los gobiernos se tratan de la manera en que están siendo

tratados.Existe una actividad constante por ser los mejores, por tener

posición e influencia en los asuntos mundiales, ¡y el partido más fuerte

es el que gana! En economía se le llama “la regla de oro”, que quiere

decir que “quien tiene el oro hace las reglas”. En política también

existe, aunque su aspecto es más darviniano.

Se trata simplemente de la “supervivencia del más apto”.En política, sin

embargo, el más apto ha llegado a significar que el partido más fuerte

lucha de la manera más sucia. Es utilizado absolutamente todo medio

disponible para mantener un excedente de ventaja sobre el adversario, y

todos son el “adversario”, no importa si son considerados amigos o

enemigos.

Esto incluye la postura psicológica indignante, la mentira, el engaño,

espiar, robar, el asesinato de los líderes del mundo, guerras de poder,

alianzas y cambios de alianzas, tratados, ayuda exterior y la presencia

de fuerzas militares donde sea posible.Guste o no, ésta es la arena real

y psicológica en la cual funcionan los gobiernos nacionales. Ningún

gobierno nacional hará nunca cualquier cosa que de ventaja a su

adversario, sin obtener nada a cambio. ¡Nunca! Es suicidio nacional.

Cualquier actividad del individuo, dentro o fuera del país, que se

interprete como dar ventaja de cualquier manera a un adversario, será

juzgada como una amenaza para la seguridad nacional. ¡Siempre!¡La

tecnología de la energía libre es la peor pesadilla para un gobierno

nacional! Abiertamente reconocida, la tecnología de la energía libre

desencadena una carrera armamentística ilimitada por todos los

gobiernos, en una tentativa final de obtener ventaja y dominación

absolutas. Piense sobre ella. ¿Piensa que Japón no se sentiría

intimidado si China tuviese la energía libre? ¿Piensa que Israel se

sentaría tranquilamente mientras Irak/Irán/Jordania adquieren energía

libre? ¿Piensa que la India permitiría que Pakistán desarrollara energía

libre? ¿Piensa que E.E.U.U. no intentaría impedir que Osama Bin Laden

consiguiera energía libre?

La energía ilimitada, disponible en la situación actual en este planeta,

conduciría a la inevitable modificación del equilibrio de la energía.

Esto podría convertirse en una guerra total para evitar que “el otro”

tuviera la ventaja de la energía abundante e ilimitada. Todos la

desearían, y al mismo tiempo desearían impedir que otros la

consiguieran.

Así pues, los gobiernos nacionales son la segunda fuerza que opera para

posponer la disponibilidad pública de la tecnología de la energía libre.

Su motivación es el “instinto de conservación”.

Este instinto de conservación funciona a tres niveles:

1. no dando ventaja indebida a un enemigo externo;

2. previniendo la acción individualizada (anarquía) capaz de poner en

riesgo las políticas energéticas oficiales dentro del país; y

3. preservando los flujos de la renta derivados de gravar fuentes de energía actualmente en uso.

Sus armas incluyen:

* la obstaculización en la emisión de patentes, bajo argumentos de seguridad nacional,

* el hostigamiento, legal e ilegal, de inventores a través de cargos

criminales, auditorías de impuestos, amenazas, intervenciones

telefónicas, detención, incendios malintencionados, el hurto de la

propiedad durante el envío, y

* un sinfín de otras intimidaciones, que hacen que resulte imposible el

negocio de construir y comercializar una máquina de energía libre.

3. Desilusión y falta de honradez en el movimiento de FE (Free Energy=Energía Libre)

La tercera fuerza que opera para posponer la disponibilidad pública de

la tecnología de la energía libre consiste en el grupo de inventores

estafadores y charlatanes. En la periferia de los grandes y

extraordinarios avances científicos, que constituyen las tecnologías de

energía libre reales, descansa un mundo sombrío de anomalías

inexplicadas, de invenciones marginales y de promotores sin escrúpulos.

Las primeras dos fuerzas utilizan constantemente a los medios para

mostrar los peores ejemplos de este grupo, distraer la atención del

público, y desacreditar los verdaderos avances, asociándolos a los

fraudes obvios.Durante los últimos 100 años han emergido docenas de

historias acerca de invenciones inusuales.

Algunas de estos conceptos cautivaron la imaginación del público de tal

forma, que se creó una mitología sobre estos sistemas que continúa hasta

día de hoy.Nombres como Hubbard, Coler y Mark Hendershot acuden

inmediatamente a la mente. Detrás de estos nombres quizás existían

verdaderas tecnologías, pero simplemente no existen suficientes datos

técnicos disponibles en el dominio público para tomar una decisión. A

pesar de que estos nombres son citados por los “desenmascaradores” como

ejemplos de fraude, siguen estando asociados a una mitología de la

energía libre. Porque la idea de la energía libre emerge de lo más hondo

de la mente subconsciente humana.Sin embargo, algunos inventores con

tecnologías marginales que demuestran anomalías útiles, han exagerado

erróneamente la importancia de su invención.

También algunos ellos han exagerado de forma equivocada la importancia

de sí mismos para inventarla. Aparece entonces una combinación de la

“fiebre del oro” y/o de un “complejo de Mesías”, que rompen por completo

cualquier contribución futura que puedan hacer. Mientras van siguiendo

el hilo de una investigación que parece aportar una gran promesa,

empiezan a intercambiar entusiasmo por hechos, con lo que a partir de

ese punto, la validez de su trabajo científico decae grandemente.

Hay una poderosa y sutil seducción que puede someter a cualquier

personalidad, si ésta llega a creer que “lleva el peso del mundo en sus

hombros”, o que es el “salvador” del mundo.Cuando las personas piensan

que pueden llegar a ser extremadamente ricas, cualquier cosa les puede

suceder. Seguir siendo objetivo y humilde, en presencia de una máquina

de energía libre operativa, requiere de una enorme disciplina

espiritual. Las psiques de muchos inventores devienen inestables

simplemente porque creen tener una máquina de energía libre.

Y a la par que la calidad del trabajo científico se deteriora, algunos

inventores empiezan también a desarrollar un complejo de persecución que

les coloca muy a la defensiva e inalcanzables.

Este proceso les imposibilita para desarrollar realmente una máquina de

energía libre, e incrementa enormemente las mitologías del fraude.Luego

están los verdaderos estafadores. En los últimos 15 años, una persona en

EE.UU. ha llevado la estafa de la energía libre a la categoría de arte

profesional. Ha ganado más de 100,000,000 de dólares americanos; ha

estado entre rejas por hacer negocio en el estado de Washington;

encarcelado en California, y todavía sigue en el negocio. Habla siempre

de una variación de uno de los verdaderos sistemas de energía libre,

vende a la gente la idea de que ellos conseguirán pronto uno de estos

sistemas, pero en última instancia vende sólo la información

promocional, no da ningún dato verdadero sobre el sistema de energía en

sí mismo. Ha sido perseguido sin compasión por las comunidades

cristianas y patriotas estadounidenses, y todavía sigue fuerte.

El actual fraude de esta persona implica hacer firmar a cientos de miles

de personas en las localidades donde instalarán una máquina de energía

libre. A cambio de instalar un generador de FE en su hogar, obtendrán

electricidad libre para toda la vida, y su compañía venderá el exceso de

energía a la empresa del servicio público local.

Tras ser convencidos de que recibirán electricidad libre para toda la

vida, compran con gusto una película de vídeo, que además ayuda a

convencer del fraude a sus amigos.Una vez que se entiende el poder y las

motivaciones de las primeras dos fuerzas de las que hemos hablado,

resulta obvio que el “plan de negocio actual” de esta persona es

inviable. Esta persona probablemente haya causado más daño al movimiento

de la energía libre en EE.UU. que cualquier otra fuerza, destruyendo la

confianza de la gente en esta tecnología.

Así pues, la tercera fuerza que pospone la disponibilidad pública de la

tecnología de la energía libre es la desilusión y la falta de honradez

dentro del propio movimiento. Las motivaciones son el

auto-engrandecimiento, la avaricia, el deseo de poder por encima de

todo, y un falso sentido de la presunción.Las armas utilizadas son: la

mentira, el engaño, el timo del “cebo y el cambio” (la “estampita”), el

autoengaño y la arrogancia, combinados con una ciencia vil.

4. Un público no-exigente

La cuarta fuerza que funciona para posponer la disponibilidad pública de

la tecnología de la energía libre es… todo el resto de nosotros. Es

fácil ver cuán despreciables y estrechas de miras son las motivaciones

de las otras fuerzas, pero esas motivaciones están también muy vivas

dentro de cada uno de nosotros.Al igual que las familias más ricas,

¿acaso cada uno de nosotros no abrigamos secretamente ilusiones de una

falsa superioridad, y deseamos controlar a los demás en vez de a

nosotros mismos?¿O acaso no podríamos “vendernos”, si el precio fuera

suficientemente alto?

Por ejemplo, si nos ofrecen ahora 1 millón de dólares en efectivo.O,

como los gobiernos: ¿no deseamos todos asegurar nuestra propia

supervivencia?Si estamos en el centro de un teatro lleno de gente y se

declara un incendio, ¿acaso no nos aterramos, y empujamos sobre todo a

los más débiles, apartándolos, para llegar a la puerta en tiempo

mínimo?O, como el inventor-estafador, ¿no negociamos una ilusión cómoda,

de vez en cuando, por un hecho incómodo? Y ¿no nos gusta pensar más en

nosotros mismos que en que otros nos den crédito?O ¿acaso no tenemos

miedo a lo desconocido, incluso si esto promete una gran recompensa?

En realidad podemos ver que las cuatro fuerzas son apenas diversos

aspectos del mismo proceso, funcionando a diversos niveles en la

sociedad. Sólo existe una fuerza que impide la disponibilidad pública de

la tecnología de la energía libre, y es el comportamiento no motivado

espiritualmente del animal humano.

En el análisis anterior, la tecnología de la energía libre es una

manifestación exterior de la abundancia Divina. Es el motor de la

economía de una sociedad iluminada — donde la gente se comporta

voluntariamente de una manera respetuosa y civilizada hacia todos; donde

cada miembro de la sociedad tiene todo lo que necesita y no desea lo

que tiene su vecino; donde la guerra y la violencia física son

comportamientos socialmente inaceptables; y donde las diferencias entre

la gente están no ya simplemente toleradas, sino vistas con agrado.El

aspecto de la tecnología de la energía libre en el dominio público es el

amanecer de una era verdaderamente civilizada. Es un acontecimiento de

nuestra época en la historia humana. Nadie puede “otorgarse el crédito”

de ella.

Nadie puede “hacerse rico” con ella. Nadie puede “mandar en el mundo”

con ella. Es, simplemente, un regalo de Dios. Nos fuerza a todos a tomar

la responsabilidad de nuestras propias acciones, y de nuestro propio

dominio del yo mismo autodisciplinado, cuando sea necesario. El mundo,

tal como está actualmente, no puede disponer de la tecnología de la

energía libre, sin haberse antes transformado totalmente en algo más.

Esta civilización ha alcanzado ya el límite de su desarrollo, porque le

han nacido las semillas de su propia transformación. A los animales

humanos no espirituales no se les puede confiar la energía libre. Harán

solamente lo que siempre han hecho, que es ventaja sin piedad sobre

cualquiera, o matarse ellos mismos en el proceso.Si se retrocede y se

lee el atlas resumido de Ayn Rand (1957), o los informes del Club de

Roma, “The Limits To Growth” (1972), llega a ser obvio que las familias

más ricas lo han comprendido así durante décadas.

Su plan es vivir en el mundo de la energía libre excluyendo

permanentemente al resto de nosotros. Esto no es nuevo. Las regalías

siempre han considerado generalmente a la población (nosotros) sus

objetivos.Lo nuevo es que ahora podemos comunicarnos todos mucho mejor

que en cualquier otro momento del pasado. Internet nos ofrece a

nosotros, la cuarta fuerza, una oportunidad para superar los esfuerzos

combinados de las otras tres fuerzas, que están impidiendo la extensión

de la tecnología de la energía libre.

La oportunidad para una sociedad más justa

Lo que está empezando a suceder es que los inventores están publicando

su trabajo en vez de patentarlo y mantenerlo secreto. Más y más gente

están entregando la información sobre estas tecnologías en libros,

vídeos y sitios Web. Aunque todavía hay mucha información inútil sobre

la energía libre en Internet, la disponibilidad de la buena información

se está incrementando rápidamente. Al final de este artículo hay una

lista de sitios Web y de otros recursos.Es imprescindible que se empiece

a recopilar toda la información que se pueda de los verdaderos sistemas

de energía libre. La razón de esto es simple. ¡Las primeras dos fuerzas

nunca permitirán que un inventor o compañía construya y venda una

máquina de energía libre a cualquiera! La única manera de conseguirlo es

construirlo uno mismo (o conseguir que un amigo más hábil lo

construya).

Esto es exactamente lo que están comenzando a hacer, de forma cauta y

silenciosa, miles de personas. Uno puede sentirse completamente

inadecuado para esta tarea, pero se empieza recopilando la información

ahora. Uno puede ser apenas un eslabón en la cadena de acontecimientos

para beneficio de otros. Hay que centrarse en lo que se puede hacer

ahora, no en cuánto queda por hacer. Los pequeños grupos de

investigación privados están resolviendo los detalles mientras usted lee

este artículo. Muchos confían en publicar sus resultados en

Internet.Todos nosotros constituimos la cuarta fuerza.

Si nos levantamos y rechazamos seguir permaneciendo ignorantes e

inactivos, podemos cambiar el curso de la historia. Es la suma de

nuestra acción combinada lo que puede marcar la diferencia. Solamente la

acción total que representa nuestro consenso puede crear el mundo que

deseamos. Las otras tres fuerzas no nos ayudarán a poner una central

eléctrica sin combustible en nuestro sótano.

No nos ayudarán a estar libres de sus manipulaciones.Sin embargo, la

tecnología de la energía libre está aquí. Es verdadera, y cambiará todo

sobre la manera en que vivimos, trabajamos y como nos relacionamos el

uno con el otro. En el análisis anterior, la tecnología de la energía

libre hace que la avaricia y el miedo para nuestra supervivencia

resulten obsoletos. Pero como en todos los ejercicios de fe espiritual,

primero debemos manifestar la generosidad y confianza en nuestras

propias vidas.La fuente de la energía libre está dentro de nosotros. Es

ese entusiasmo de expresarse libremente.

Es nuestra intuición espiritual dirigida, que se expresa sin la

distracción, intimidación o manipulación. Es nuestro buen corazón

abierto. Idealmente, las tecnologías de la energía libre sostienen a una

sociedad justa donde cada uno tiene suficiente alimento, ropa, abrigo,

autoestima y tiempo libre para contemplar los significados espirituales

más altos de la vida. ¿Acaso no debemos enfrentarnos a nuestros propios

miedos, y pasar a la acción para crear este futuro para los hijos de

nuestros hijos?

Quizás no seamos los únicos esperando actuar con una mayor verdad.La

tecnología de la energía libre está aquí. Ha estado aquí durante

décadas. Las nuevas tecnologías de la comunicación, e Internet, han

rasgado el velo del secreto de este hecho notable. Personas de todo el

mundo están empezando a construir dispositivos de energía libre para su

propio uso. Los banqueros y los gobiernos no quieren que esto suceda,

pero no pueden pararlo.En un futuro cercano, las enormes inestabilidades

económicas y las guerras serán utilizadas para distraer a la gente de

unirse al movimiento de la energía libre. Esencialmente, no habrá

cobertura de los medios más importantes sobre este aspecto ni sobre lo

que esté sucediendo.

Se divulgará simplemente como guerras y guerras civiles que entran en

erupción por todas partes, conduciendo al envío de las “fuerzas de paz”

de la ONU a más y más países.La sociedad occidental está cayendo en

espiral hacia la autodestrucción debido a los efectos acumulados a largo

plazo de la avaricia y de la corrupción. La disponibilidad general de

la tecnología de la energía libre no puede detener esta tendencia, sólo

puede reforzarla.

Sin embargo, si se tiene un dispositivo de energía libre, se puede

colocar en una mejor posición para sobrevivir la transición política,

social, económica que está en curso. Ningún gobierno nacional

sobrevivirá este proceso. La pregunta es entonces, en última instancia

¿quién controlará el gobierno del mundo que emerge? ¿La primera fuerza o

la cuarta fuerza?La última gran guerra está casi sobre nosotros. Las

semillas están sembradas. Después de esto vendrá el principio de una

civilización verdadera. Los que rechacen luchar sobrevivirán para ver el

amanecer del mundo de la energía libre. Os desafío a estar entre los

que lo intentan.