20130228

20130227

La "Learning Pyramid"

La "Learning Pyramid"

Les aseguro que intento mantenerme relajado y educado en las discusiones pedagógicas, pero a veces me rindo al pronto que me domina y acabo echando sapos y culebras por la boca. Este fue el caso cuando recientemente alguien hizo mención en un debate de la "pirámide del aprendizaje" con la intención de demostrar que la escuela tradicional no enseña nada porque se basa en el papel transmisor del maestro, mientras que la escuela constructivista, activa, que trabaja por proyectos, es la repera. A la gente que utiliza estos argumentos no les puedes preguntar por qué si es tan buena hay tantas que obtienen resultados mediocres, porque entonces te critican por resultadista y se quedan tan anchos. Así que hay que criticarlos por clasistas, que eso les escuece mucho.

Si ustedes quieren buscar por internet información sobre la "learning pyramid" se encontrarán con diferentes versiones de la misma (varían los porcentajes asignados a cada acción e incluso el orden de las acciones) y con abundantes artículos a favor y en contra.

Yo no tengo inconveniente en aceptar los argumentos a favor. Parece que tiene sentido defender que uno comprende bien las cosas cuando se ve en la situación de discutirlas ante un público crítico. El problema es que para demostrar, discutir, practicar y, sobre todo, enseñar algo a alguien, tienes que tener algo que demostrar, discutir, practicar o enseñar. Si no es así, te limitas a enseñar bobadas.

Es decir, la escuela progre, tan moderna ella, cae tan contenta en la trampa del famoso "Efecto Mateo". Recuerden el Evangelio: "Al que tiene, se le dará, y al que no tiene, aun lo que tiene, se le quitará". Quiero decir que esta pirámide funciona de maravilla con los niños que llegan al cole sabiendo cosas. Y funciona tanto mejor cuantas más cosas traen aprendidas de casa. Si poseen un vocabulario amplio y una cultura general extensa, adelante con ella. ¿Pero qué ocurre con los niños de medios culturales desfavorecidos a los que ponemos en situación de explicar lo que no saben? ¡Pues que cometemos un tremendo fraude pedagógico, claro!

Si queremos que nuestros alumnos enseñen lo que saben, asegurémonos antes que les hemos dado conocimientos, cuantos más, mejor.

20130225

La transición hacia la Era del Hidrógeno. ¿La Tercera Revolución industrial?

La transición hacia la Era del Hidrógeno. ¿La Tercera Revolución industrial?

El hombre ha utilizado diversas fuentes de energía, desde las etapas más tempranas de su existencia, que le han permitido evolucionar hacia un mayor grado de desarrollo en sus modos de vida.

En nuestra sociedad actual el control de la energía representa el poder de la civilización además del control de la distribución de los bienes en el planeta. Los países menos poderosos no tienen energía eléctrica. Asegurar el acceso a la electricidad de todo el mundo, según algunos analistas económicos, puede ser posible gracias a la energía renovable del hidrógeno. Hay indicios para pensar que estamos en el fin de la era del petróleo. La cuenta atrás de los combustibles fósiles es inevitable y ya ha comenzado. Es previsible, por tanto, que en un futuro inmediato asistamos a una crisis energética que cambiaría el actual modo de vida de nuestras sociedades, debido a la llegada del hidrógeno como un combustible versátil y eficaz, el más limpio que existe. Se espera que eso se traduzca en un cambio revolucionario que transformará las relaciones sociales y económicas en el planeta. Según algunos políticos, analistas y expertos estaríamos hablando de un nuevo orden mundial. ¿Pero realmente estamos ante un verdadero cambio histórico? ¿Una Tercera Revolución Industrial similar a la que supuso la llegada del petróleo y la electricidad?

El consumo de energía y el progreso en la Historia

Comenzando por el hombre prehistórico; la invención del fuego supone un paso decisivo en la historia de la humanidad. Con la aparición del fuego se inicia un proceso en el que la combustión de materiales para extraer su energía será la base del progreso humano. El hombre prehistórico quemando la madera de los árboles, aprende a dominar y a utilizar el fuego. Descubre el poder que esa combustión representa y aprende a canalizar esta energía para diversos usos. A partir de esta experiencia cambiaron los hábitos en su alimentación y en sus modos de vida. Sin ese primer paso no sabemos qué distinto camino hubiéramos recorrido como especie humana.

Llegado el Neolítico, siguió siendo esencial quemar la madera como conbustible para conseguir fundir los metales a elevadísimas temperaturas, una auténtica revolución, de nuevo, en los modos de vida de las primeras comunidades sedentarias.

Tuvo que pasar mucho tiempo hasta que se diera paso a la combustión del carbón como fuente de energía, dando lugar a la Revolución Industrial mitad del s.XVIII y principios del s.XX que supuso el mayor conjunto de transformaciones socioeconómicas, tecnológicas y culturales de la Historia de la humanidad, desde el Neolítico. La máquina de vapor impulsada por la hulla-un tipo de carbón mineral-fue el motor inicial de la Revolución Industrial.

Ya entre 1870 y 1914 llegó la combustión del petróleo y sus derivados con la Segunda Revolución Industrial. Los “hidrocarburos” (Petróleo) y la electricidad como fuente de energía fueron las principales innovaciones del s.XX. Esta etapa significa un proceso de revoluciones tecnológicas y de desarrollo de las industria eléctrica, del petróleo y del acero, la introducción del motor de combustión interna, la llegada del automóvil, y la invención del teléfono.

Así pues, hemos visto como el hombre ha ido utilizando a lo largo de sus historia en el planeta- aunque en los últimos siglos no siempre de manera sostenible y ecológica-estas materias combustibles para obtener energía ,y con ello ha logrado un mayor progreso; de la madera al carbón y del carbón al petróleo.

En nuestra sociedad actual el control de la energía representa el poder de la civilización además del control de la distribución de los bienes en el planeta. Los países menos poderosos no tienen energía eléctrica. Asegurar el acceso a la electricidad de todo el mundo, según algunos analistas económicos, puede ser posible gracias a la energía renovable del hidrógeno. Hay indicios para pensar que estamos en el fin de la era del petróleo. La cuenta atras de los combustibles fósiles es inevitable y ya ha comenzado.

La era del Hidrógeno :Un nuevo Orden Mundial

Es previsible que en un futuro inmediato asistamos a una crisis energética que cambiaría el actual modo de vida de nuestras sociedades, debido a la llegada del hidrógeno como un combustible versatil y eficaz, el más limpio que existe. Se espera que eso se traduzca en un cambio revolucionario que transformará las relaciones sociales y económicas en el planeta. Según algunos políticos, analistas y expertos estaríamos hablando de un nuevo orden mundial. ¿Pero realmente estamos ante un verdadero cambio histórico? ¿Una Tercera Revolución Industrial similar a la que supuso la llegada del petróleo y la electricidad?

El progreso humano sostenible :La Revolución del Hidrógeno

El hidrógeno es el átomo más simple del Universo y el más abundante, ya que está en todas partes. Pero a pesar de ser el elemento químico más ligero y abundante en el universo, es un combustible que no se puede aprovechar directamente, no es una fuente de energía propiamente dicha, sino un portador de energía. El problema es que no existen yacimientos de hidrógeno. Éste se encuentra en la madera, el carbón, el petróleo y el gas, pero sobre todo en el agua. La manera más limpia de extraer el hidrógeno es directamente del agua, el componente más abundante de la superficie terrestre. Y la gran ventaja del hidrógeno es que al ser un gas puede almacenarse.

Muchos científicos e investigadores siguen experimentando las aplicaciones de la teoría de William Grove de 1839, quien generó corriente eléctrica de una reacción electroquímica entre hidrógeno y oxígeno sin generar gases, sólo agua.

Dos siglos después, se siguen desarrollando nuevas técnicas para encontrar la manera de comprimir y almacenar el elemento más abundante del universo-el hidrógeno- en una pila de combustible, que generaría la energía necesaria para hacer funcionar los automóviles, vehículos de transporte, e incluso plantas industriales o teléfonos móviles sin producir gases contaminantes, únicamente agua y calor.

El hidrógeno se nos presenta como una excelente solución para almacenar energías renovables. Pero para poder extraer el hidrógeno se necesita de otra fuente de energía. La manera más limpia de extraer el hidrógeno es del agua, pero para poder extraerlo se sigue necesitando electricidad que podría extraerse del sol de manera limpia. Actualmente se usan plantas de gas para obtener el hidrógeno, el objetivo de los expertos es sacarlo del agua. También se están realizando experimentos para extraerlo algún día directamente de la luz solar.

En resumidas cuentas; se trata de convertir el hidrógeno en una fuente de energía renovable masiva capaz de mantener las exigencias energéticas de nuestras sociedades y de poner fin a una etapa insostenible de abuso de los recursos energéticos tradicionales.

Actualmente, puede que tengamos la capacidad para pasar de los combustibles fósiles- como el carbón o el petróleo-al hidrógeno con nuevas infraestructuras. Otro aspecto importante es que el hidrógeno se puede almacenar. Esto significa que podríamos disponer de importantes reservas energéticas.

Pero ¿Se trata de una seria posibilidad o de una bonita utopía?

Algunos críticos de la ”era del hidrógeno” piensan que estamos ante la utopía de algunos visionarios.

Sin embargo expertos como Jeremy Rifkin, presidente de la Fundación de Tendencias económicas, asesor del gobierno norteamericano, y creador de “La Economía del Hidrógeno” se han convertido en uno de los máximos defensores de las aplicaciones de la economía del hidrógeno. Rifkin opina que la revolucióndel hidrógeno producirá un cambio histórico espectacular ” similar a la unión de la revolución de la imprenta con la máquina de vapor y el ferrocarril que se tradujo en la primera revolución industrial y cuyo efecto multiplicador se materializó en el s.XIX. La Segunda revolución industrial tuvo un impacto tan potente por la unión del telégrafo al teléfono y la electricidad con el petróleo y el motor de combustiòn interna. Para Rifkin, la tercera Revolución consistirá en una distribución descentralizada del hidrógeno”

Es decir, sus palabras se traducen en cuatro frases: Produccción a gran escala de hidrógeno. Descentralización de la producción de energías. Una ola de desarrolo tecnológico con oportunidad para todos. Producción de hidrógeno para uso propio. Un cambio radical en los modelos de la economía mundial.

Si así fuera estamos a las puertas de una nueva era energética. Una Tercera Revolución Industrial.

Si tomamos como referencia cómo se gestó el proceso de la primera gran revolución industrial sabremos que estos cambios forman parte de un proceso de aplicaciones tecnológicas que conducen a el éxito esperado. La máquina de vapor fue el motor que hizo posible el cambió energético en la primera Revolución Industrial. Pero hubieron algunos intentos hasta llegar hasta la sofisticada máquina de Watt, y siguieron las mejoras, que fueron desplazando a los tradicionales motores como el animal de tiro, el molino o la propia fuerza del hombre y que en Inglaterra, en el contexto de una incipiente Revolución Industrial en los siglos XVII y XVIII, llevaron desde los rudimentarios primeros aparatos sin aplicación práctica a la invención del motor universal que llegó a implantarse en todas las industrias y a utilizarse en el transporte.

Defensores de la economía del Hidrógeno

Algunas compañías, como Honda, DaimlerChrysler, Ford Motor Company, General Motors Corporation/Opel, Hyundai Motor Company, Kia Motors Corporation, la alianza Renault SA y Nissan Motor Corporation y Toyota Motor Corporation están desarrollando proyectos relacionados con los vehículos de hidrógeno. Algunas de ellas incluso han apostado estratégicamente por un futuro energético basado en las tecnologías de hidrógeno, una corriente que ha dado lugar al concepto de Sociedad del Hidrógeno, que a menudo se intercambia con el de economía del hidrógeno.

Islandia por ejemplo, pretende que toda su flota pesquera funcione con motores de hidrógeno para el 2050.

Obstáculos actuales

Aunque se están realizado importantes avances tecnológicos, la implantación de la economía del hidrógeno no es inmediata y requiere aún dar respuesta a importantes retos tecnológicos, económicos y sociales que se describen a continuación.

Desde el punto de vista de la producción del hidrógeno, hay que considerar que los métodos actuales resultan costosos y se basan principalmente en la gasificación de combustibles fósiles a altas presiones y temperaturas. Los procesos basados en energías renovables o energía nuclear no se encuentran suficientemente desarrollados y a nivel industrial su coste es aún mayor. Por otro lado, para dar respuesta a una demanda global de este tipo de energía, se necesitaría el desarrollo de un sistema de distribución de hidrógeno similar al que existe hoy en día para la gasolina.

El almacenamiento supone otro reto aún por resolver ya que, debido a su baja densidad energética, se necesitan enormes volúmenes de hidrógeno para alimentar procesos con alta demanda energética. En la actualidad se investiga en el desarrollo de tanques de alta presión, adsorbentes porosos e hidruros metálicos que permitan almacenar cantidades suficientes de este compuesto en espacios reducidos.

El precio actual de las pilas de combustible y su fiabilidad supone otra barrera a la aplicación masiva de esta tecnología. El uso de electrodos con catalizadores de metales nobles como el paladio y el platino, con un elevado precio de mercado, y los problemas de envenenamiento, sobre todo en procesos que utilizan hidrógeno de menor pureza, también son objeto de investigación.

Otro de los aspectos a superar es el de la seguridad ya que el hidrógeno es un compuesto altamente inflamable y potencialmente explosivo en contacto con el oxígeno de la atmósfera. Por ello se deben adoptar normativas de seguridad específicas que son diferentes a las que hoy se aplican con éxito para otros compuestos como la gasolina, el butano o el gas natural.

El hombre ha utilizado diversas fuentes de energía, desde las etapas más tempranas de su existencia, que le han permitido evolucionar hacia un mayor grado de desarrollo en sus modos de vida.

En nuestra sociedad actual el control de la energía representa el poder de la civilización además del control de la distribución de los bienes en el planeta. Los países menos poderosos no tienen energía eléctrica. Asegurar el acceso a la electricidad de todo el mundo, según algunos analistas económicos, puede ser posible gracias a la energía renovable del hidrógeno. Hay indicios para pensar que estamos en el fin de la era del petróleo. La cuenta atrás de los combustibles fósiles es inevitable y ya ha comenzado. Es previsible, por tanto, que en un futuro inmediato asistamos a una crisis energética que cambiaría el actual modo de vida de nuestras sociedades, debido a la llegada del hidrógeno como un combustible versátil y eficaz, el más limpio que existe. Se espera que eso se traduzca en un cambio revolucionario que transformará las relaciones sociales y económicas en el planeta. Según algunos políticos, analistas y expertos estaríamos hablando de un nuevo orden mundial. ¿Pero realmente estamos ante un verdadero cambio histórico? ¿Una Tercera Revolución Industrial similar a la que supuso la llegada del petróleo y la electricidad?

El consumo de energía y el progreso en la Historia

Comenzando por el hombre prehistórico; la invención del fuego supone un paso decisivo en la historia de la humanidad. Con la aparición del fuego se inicia un proceso en el que la combustión de materiales para extraer su energía será la base del progreso humano. El hombre prehistórico quemando la madera de los árboles, aprende a dominar y a utilizar el fuego. Descubre el poder que esa combustión representa y aprende a canalizar esta energía para diversos usos. A partir de esta experiencia cambiaron los hábitos en su alimentación y en sus modos de vida. Sin ese primer paso no sabemos qué distinto camino hubiéramos recorrido como especie humana.

Llegado el Neolítico, siguió siendo esencial quemar la madera como conbustible para conseguir fundir los metales a elevadísimas temperaturas, una auténtica revolución, de nuevo, en los modos de vida de las primeras comunidades sedentarias.

Tuvo que pasar mucho tiempo hasta que se diera paso a la combustión del carbón como fuente de energía, dando lugar a la Revolución Industrial mitad del s.XVIII y principios del s.XX que supuso el mayor conjunto de transformaciones socioeconómicas, tecnológicas y culturales de la Historia de la humanidad, desde el Neolítico. La máquina de vapor impulsada por la hulla-un tipo de carbón mineral-fue el motor inicial de la Revolución Industrial.

Ya entre 1870 y 1914 llegó la combustión del petróleo y sus derivados con la Segunda Revolución Industrial. Los “hidrocarburos” (Petróleo) y la electricidad como fuente de energía fueron las principales innovaciones del s.XX. Esta etapa significa un proceso de revoluciones tecnológicas y de desarrollo de las industria eléctrica, del petróleo y del acero, la introducción del motor de combustión interna, la llegada del automóvil, y la invención del teléfono.

Así pues, hemos visto como el hombre ha ido utilizando a lo largo de sus historia en el planeta- aunque en los últimos siglos no siempre de manera sostenible y ecológica-estas materias combustibles para obtener energía ,y con ello ha logrado un mayor progreso; de la madera al carbón y del carbón al petróleo.

En nuestra sociedad actual el control de la energía representa el poder de la civilización además del control de la distribución de los bienes en el planeta. Los países menos poderosos no tienen energía eléctrica. Asegurar el acceso a la electricidad de todo el mundo, según algunos analistas económicos, puede ser posible gracias a la energía renovable del hidrógeno. Hay indicios para pensar que estamos en el fin de la era del petróleo. La cuenta atras de los combustibles fósiles es inevitable y ya ha comenzado.

La era del Hidrógeno :Un nuevo Orden Mundial

Es previsible que en un futuro inmediato asistamos a una crisis energética que cambiaría el actual modo de vida de nuestras sociedades, debido a la llegada del hidrógeno como un combustible versatil y eficaz, el más limpio que existe. Se espera que eso se traduzca en un cambio revolucionario que transformará las relaciones sociales y económicas en el planeta. Según algunos políticos, analistas y expertos estaríamos hablando de un nuevo orden mundial. ¿Pero realmente estamos ante un verdadero cambio histórico? ¿Una Tercera Revolución Industrial similar a la que supuso la llegada del petróleo y la electricidad?

El progreso humano sostenible :La Revolución del Hidrógeno

El hidrógeno es el átomo más simple del Universo y el más abundante, ya que está en todas partes. Pero a pesar de ser el elemento químico más ligero y abundante en el universo, es un combustible que no se puede aprovechar directamente, no es una fuente de energía propiamente dicha, sino un portador de energía. El problema es que no existen yacimientos de hidrógeno. Éste se encuentra en la madera, el carbón, el petróleo y el gas, pero sobre todo en el agua. La manera más limpia de extraer el hidrógeno es directamente del agua, el componente más abundante de la superficie terrestre. Y la gran ventaja del hidrógeno es que al ser un gas puede almacenarse.

Muchos científicos e investigadores siguen experimentando las aplicaciones de la teoría de William Grove de 1839, quien generó corriente eléctrica de una reacción electroquímica entre hidrógeno y oxígeno sin generar gases, sólo agua.

Dos siglos después, se siguen desarrollando nuevas técnicas para encontrar la manera de comprimir y almacenar el elemento más abundante del universo-el hidrógeno- en una pila de combustible, que generaría la energía necesaria para hacer funcionar los automóviles, vehículos de transporte, e incluso plantas industriales o teléfonos móviles sin producir gases contaminantes, únicamente agua y calor.

El hidrógeno se nos presenta como una excelente solución para almacenar energías renovables. Pero para poder extraer el hidrógeno se necesita de otra fuente de energía. La manera más limpia de extraer el hidrógeno es del agua, pero para poder extraerlo se sigue necesitando electricidad que podría extraerse del sol de manera limpia. Actualmente se usan plantas de gas para obtener el hidrógeno, el objetivo de los expertos es sacarlo del agua. También se están realizando experimentos para extraerlo algún día directamente de la luz solar.

En resumidas cuentas; se trata de convertir el hidrógeno en una fuente de energía renovable masiva capaz de mantener las exigencias energéticas de nuestras sociedades y de poner fin a una etapa insostenible de abuso de los recursos energéticos tradicionales.

Actualmente, puede que tengamos la capacidad para pasar de los combustibles fósiles- como el carbón o el petróleo-al hidrógeno con nuevas infraestructuras. Otro aspecto importante es que el hidrógeno se puede almacenar. Esto significa que podríamos disponer de importantes reservas energéticas.

Pero ¿Se trata de una seria posibilidad o de una bonita utopía?

Algunos críticos de la ”era del hidrógeno” piensan que estamos ante la utopía de algunos visionarios.

Sin embargo expertos como Jeremy Rifkin, presidente de la Fundación de Tendencias económicas, asesor del gobierno norteamericano, y creador de “La Economía del Hidrógeno” se han convertido en uno de los máximos defensores de las aplicaciones de la economía del hidrógeno. Rifkin opina que la revolucióndel hidrógeno producirá un cambio histórico espectacular ” similar a la unión de la revolución de la imprenta con la máquina de vapor y el ferrocarril que se tradujo en la primera revolución industrial y cuyo efecto multiplicador se materializó en el s.XIX. La Segunda revolución industrial tuvo un impacto tan potente por la unión del telégrafo al teléfono y la electricidad con el petróleo y el motor de combustiòn interna. Para Rifkin, la tercera Revolución consistirá en una distribución descentralizada del hidrógeno”

Es decir, sus palabras se traducen en cuatro frases: Produccción a gran escala de hidrógeno. Descentralización de la producción de energías. Una ola de desarrolo tecnológico con oportunidad para todos. Producción de hidrógeno para uso propio. Un cambio radical en los modelos de la economía mundial.

Si así fuera estamos a las puertas de una nueva era energética. Una Tercera Revolución Industrial.

Si tomamos como referencia cómo se gestó el proceso de la primera gran revolución industrial sabremos que estos cambios forman parte de un proceso de aplicaciones tecnológicas que conducen a el éxito esperado. La máquina de vapor fue el motor que hizo posible el cambió energético en la primera Revolución Industrial. Pero hubieron algunos intentos hasta llegar hasta la sofisticada máquina de Watt, y siguieron las mejoras, que fueron desplazando a los tradicionales motores como el animal de tiro, el molino o la propia fuerza del hombre y que en Inglaterra, en el contexto de una incipiente Revolución Industrial en los siglos XVII y XVIII, llevaron desde los rudimentarios primeros aparatos sin aplicación práctica a la invención del motor universal que llegó a implantarse en todas las industrias y a utilizarse en el transporte.

Defensores de la economía del Hidrógeno

Algunas compañías, como Honda, DaimlerChrysler, Ford Motor Company, General Motors Corporation/Opel, Hyundai Motor Company, Kia Motors Corporation, la alianza Renault SA y Nissan Motor Corporation y Toyota Motor Corporation están desarrollando proyectos relacionados con los vehículos de hidrógeno. Algunas de ellas incluso han apostado estratégicamente por un futuro energético basado en las tecnologías de hidrógeno, una corriente que ha dado lugar al concepto de Sociedad del Hidrógeno, que a menudo se intercambia con el de economía del hidrógeno.

Islandia por ejemplo, pretende que toda su flota pesquera funcione con motores de hidrógeno para el 2050.

Obstáculos actuales

Aunque se están realizado importantes avances tecnológicos, la implantación de la economía del hidrógeno no es inmediata y requiere aún dar respuesta a importantes retos tecnológicos, económicos y sociales que se describen a continuación.

Desde el punto de vista de la producción del hidrógeno, hay que considerar que los métodos actuales resultan costosos y se basan principalmente en la gasificación de combustibles fósiles a altas presiones y temperaturas. Los procesos basados en energías renovables o energía nuclear no se encuentran suficientemente desarrollados y a nivel industrial su coste es aún mayor. Por otro lado, para dar respuesta a una demanda global de este tipo de energía, se necesitaría el desarrollo de un sistema de distribución de hidrógeno similar al que existe hoy en día para la gasolina.

El almacenamiento supone otro reto aún por resolver ya que, debido a su baja densidad energética, se necesitan enormes volúmenes de hidrógeno para alimentar procesos con alta demanda energética. En la actualidad se investiga en el desarrollo de tanques de alta presión, adsorbentes porosos e hidruros metálicos que permitan almacenar cantidades suficientes de este compuesto en espacios reducidos.

El precio actual de las pilas de combustible y su fiabilidad supone otra barrera a la aplicación masiva de esta tecnología. El uso de electrodos con catalizadores de metales nobles como el paladio y el platino, con un elevado precio de mercado, y los problemas de envenenamiento, sobre todo en procesos que utilizan hidrógeno de menor pureza, también son objeto de investigación.

Otro de los aspectos a superar es el de la seguridad ya que el hidrógeno es un compuesto altamente inflamable y potencialmente explosivo en contacto con el oxígeno de la atmósfera. Por ello se deben adoptar normativas de seguridad específicas que son diferentes a las que hoy se aplican con éxito para otros compuestos como la gasolina, el butano o el gas natural.

20130218

Estados Unidos da el visto bueno para el primer "ojo biónico"

Estados Unidos da el visto bueno para el primer "ojo biónico"

Esta prótesis se ha creado para los enfermos de retinosis pigmentaria

(RP), una enfermedad ocular genética rara que daña las células

sensibles a la luz que cubren la retina. Esta enfermedad genera la

disminución de la visión nocturna o cuando hay poca luz, pérdida de la

visión lateral y de la central y en casos muy graves, la ceguera.

"Se trata de un dispositivo que se implanta quirúrgicamente y proporciona una opción para los pacientes que han perdido la vista por RP", dijo el director del Centro de la FDA para Dispositivos y Salud Radiológica, Jeffrey Shuren. El dispositivo puede ayudar a los adultos que han perdido la capacidad de percibir formas y movimiento y así puedan llevar a cabo día a día las actividades.

El Argus II cuenta con una unidad de procesamiento de video portátil. Esta unidad está compuesta por una pequeña cámara de video y un transmisor montado en unas gafas. Esto junto a unos electrodos que se implantan en la retina del paciente hacen posible que la VPU transforme las imágenes de la cámara en datos electrónicos que se transmiten a una matriz de electrodos que se implantan en la retina del paciente. Estos datos son transformados en impulsos por los electrodos y estimulan la retina que produce las imágenes.

La compañía ha realizado un ensayo clínico donde 30 personas, con con una agudeza visual por debajo de 1/10, frente a los 10/10 que constituyen la norma, han recibido el trasplante. Tras varias pruebas encontraron una agudeza visual que les permitió distinguir formas en blanco y negro.

La prótesis sólo podrá ser implantada en mayores de 25 años y está disponible a un precio de 73.000 euros según un responsable de la compañía con base cerca de Los Ángeles. Se estima que en Estados Unidos 100.000 personas padecen retinosis pigmentaria.

Enlaces relacionados:

La Administración de Alimentos y Medicamentos de Estados Unidos (FDA) ha aprobado el primer dispositivo para implantar en retinas

con el objetivo de devolver la visión. La prótesis, conocida con el

nombre Argus II ha sido desarrollada por la empresa californiana Second

Sight Medical Products.

"Se trata de un dispositivo que se implanta quirúrgicamente y proporciona una opción para los pacientes que han perdido la vista por RP", dijo el director del Centro de la FDA para Dispositivos y Salud Radiológica, Jeffrey Shuren. El dispositivo puede ayudar a los adultos que han perdido la capacidad de percibir formas y movimiento y así puedan llevar a cabo día a día las actividades.

El Argus II cuenta con una unidad de procesamiento de video portátil. Esta unidad está compuesta por una pequeña cámara de video y un transmisor montado en unas gafas. Esto junto a unos electrodos que se implantan en la retina del paciente hacen posible que la VPU transforme las imágenes de la cámara en datos electrónicos que se transmiten a una matriz de electrodos que se implantan en la retina del paciente. Estos datos son transformados en impulsos por los electrodos y estimulan la retina que produce las imágenes.

La compañía ha realizado un ensayo clínico donde 30 personas, con con una agudeza visual por debajo de 1/10, frente a los 10/10 que constituyen la norma, han recibido el trasplante. Tras varias pruebas encontraron una agudeza visual que les permitió distinguir formas en blanco y negro.

La prótesis sólo podrá ser implantada en mayores de 25 años y está disponible a un precio de 73.000 euros según un responsable de la compañía con base cerca de Los Ángeles. Se estima que en Estados Unidos 100.000 personas padecen retinosis pigmentaria.

Enlaces relacionados:

20130217

El meteorito de Rusia liberó una energía 30 veces superior a la bomba de Hiroshima

del artículo, destacar la intención de hacer comprensibles las magnitudes.. como cuando una superficie se expresa en "campos de fútbol"..

El meteorito de Rusia liberó una energía 30 veces superior a la bomba de Hiroshima

El meteorito de 17 metros que ayer dejó más de 1.100 de heridos en la provincia rusa de Cheliabinsk, en los Urales, liberó una energía de 500 kilotones, una treintena de veces superior a la bomba atómica de Hiroshima, según informó la agencia espacial de Estados Unidos (NASA).

"Un evento de esta magnitud ocurre una vez en 100 años como promedio", señaló Paul Chodas, colaborador del programa de objetos cercanos a la Tierra en el laboratorio de propulsión a chorro de la NASA. "Cuando una bola de fuego es de ese tamaño, numerosos meteoritos pueden alcanzar la superficie y es probable que en este caso lo hayan hecho varios de gran tamaño", dijo.

Los datos infrasónicos recogidos indican que la caída del bólido, desde su entrada en la atmósfera hasta la desintegración, duró 32,5 segundos, y su señal fue recogida por once de las 45 estaciones de seguimiento situadas en 35 países. Su trayectoria, no obstante, fue muy diferente a la del asteroide 2012 DA14 que algunas horas después pasó cerca de la Tierra, por lo que los científicos descartan la relación entre ambos.

Expertos del Ministerio ruso de Emergencias siguen buscando fragmentos del bólido que, según una hipótesis, pudo haber caído en el lago Chebarkul, cerca de Cheliábinsk. Un grupo de seis buzos se encargará de comprobar esta versión en las próximas horas, comunicó la portavoz de Emergencias, Irina Rossius, a la agencia oficial de noticias rusa, RIA Novosti.

El Ministerio de Emergencias ruso estima que los heridos alcanzan los 1.145, en su gran mayoría leves, aunque 50 personas necesitaron hospitalización, entre ellas, una mujer de 52 años con la fractura de dos vértebras que ha sido trasladada hoy sábado en un avión especial a Moscú. El Ministerio del Interior menciona la cifra de 1.200 heridos.

Según los datos de última hora, el bólido reventó ventanas y causó otros daños en más de 3.700 edificios residenciales y más de 700 instalaciones públicas. La superficie total de cristales rotos alcanza 200.000 metros cuadrados.

El meteorito de Rusia liberó una energía 30 veces superior a la bomba de Hiroshima

El meteorito de 17 metros que ayer dejó más de 1.100 de heridos en la provincia rusa de Cheliabinsk, en los Urales, liberó una energía de 500 kilotones, una treintena de veces superior a la bomba atómica de Hiroshima, según informó la agencia espacial de Estados Unidos (NASA).

"Un evento de esta magnitud ocurre una vez en 100 años como promedio", señaló Paul Chodas, colaborador del programa de objetos cercanos a la Tierra en el laboratorio de propulsión a chorro de la NASA. "Cuando una bola de fuego es de ese tamaño, numerosos meteoritos pueden alcanzar la superficie y es probable que en este caso lo hayan hecho varios de gran tamaño", dijo.

Los datos infrasónicos recogidos indican que la caída del bólido, desde su entrada en la atmósfera hasta la desintegración, duró 32,5 segundos, y su señal fue recogida por once de las 45 estaciones de seguimiento situadas en 35 países. Su trayectoria, no obstante, fue muy diferente a la del asteroide 2012 DA14 que algunas horas después pasó cerca de la Tierra, por lo que los científicos descartan la relación entre ambos.

Expertos del Ministerio ruso de Emergencias siguen buscando fragmentos del bólido que, según una hipótesis, pudo haber caído en el lago Chebarkul, cerca de Cheliábinsk. Un grupo de seis buzos se encargará de comprobar esta versión en las próximas horas, comunicó la portavoz de Emergencias, Irina Rossius, a la agencia oficial de noticias rusa, RIA Novosti.

El Ministerio de Emergencias ruso estima que los heridos alcanzan los 1.145, en su gran mayoría leves, aunque 50 personas necesitaron hospitalización, entre ellas, una mujer de 52 años con la fractura de dos vértebras que ha sido trasladada hoy sábado en un avión especial a Moscú. El Ministerio del Interior menciona la cifra de 1.200 heridos.

Según los datos de última hora, el bólido reventó ventanas y causó otros daños en más de 3.700 edificios residenciales y más de 700 instalaciones públicas. La superficie total de cristales rotos alcanza 200.000 metros cuadrados.

20130216

Así fue el paso del asteroide 2012 DA14 junto a la Tierra

Telescopios de todo el mundo han seguido este viernes el paso de 2012 DA14, el asteroide conocido que más cerca pasará de la superficie de la Tierra. El objeto ha cruzado el cielo nocturno sobre Sumatra (Indonesia), a tan sólo 27.860 kilómetros de la Tierra, y continuó su travesía cósmica a unos 28.100 kilómetros por hora, informó la agencia espacial estadounidense NASA.

La roca, de unos 45 metros y unas 130.000 toneladas, es el objeto espacial de mayor tamaño que se haya acercado tanto a la Tierra desde que la NASA ha seguido el rastro de los asteroides durante más de medio siglo.

La mayor aproximación ocurrió a las 19.24 GMT, cuando el asteroide estuvo unos 8.500 kilómetros por debajo de la región donde orbitan unos 400 satélites geoestacionarios.

20130215

El prodigioso y desaparecido artificio que Juanelo construyó en Toledo

El prodigioso y desaparecido artificio que Juanelo construyó en Toledo

El 23 de febrero de 1569, en Toledo, se puso en funcionamiento un artificio mecánico capaz de subir al día más de 14.000 litros de agua desde el río Tajo hasta el alcázar de la ciudad. Eran 100 metros de desnivel, una altura que había resultado insalvable para la tecnología de la época, pero Juanelo Turriano lo había conseguido. Cómo lo hizo es, todavía hoy, motivo de debate.

Juanelo Turriano, de nacimiento Giovanni Torriani, nació en el Milanesado en 1501. Poco se conoce poco de su infancia. Su leyenda lo retrata como un pastorcillo de familia humilde dotado con un talento innato para la astronomía. Sin embargo, parece más realista pensar que fue su amigo Giorgio Fondulo, un profesor de la Universidad de Pavía, el que lo inició en dicha ciencia.

Según algunos, Turriano habría comenzando a formarse trabajando en el taller de su padre, del que se desconoce el oficio, pero al que el propio Turriano se refiere como “maestro” en alguno de sus escritos. Según otros, su padre era sólo un humilde molinero del río Po. En cualquier caso, se da por hecho que Turriano no acudió a la universidad, sino que adquirió la mayor parte de sus conocimientos mediante la práctica y no la teórica. Aunque no por ello era un iletrado analfabeto.

Años más tarde, ingresaría como aprendiz en algún taller de relojería de Cremona, donde, con el tiempo, conseguiría el grado de maestro. Posteriormente, se mudaría a Milán, donde daría sus primeros pasos como inventor de máquinas ingeniosas. Diseñó una potente grúa, una máquina para dragar la laguna de Venecia (auténtico desafío de la ingeniera italiana de la época) y mejoró algunas bombas de agua.

En 1530, Turriano conocería a Carlos V durante su visita a Milán. Francesco II Sforza, duque de la ciudad, quiso obsequiar al emperador, un apasionado de los relojes, con el astrario de Giovanni Dondi, que era considerado una maravilla de la época. Turriano recibió la distinguida misión de volver a ponerlo en marcha, aunque, finalmente, se empeñó en construir uno nuevo. Le llevó más de 20 años de trabajo, pero Carlos V quedó encantando con su obra, por lo que le concedió una pensión vitalicia y le encargó otro planetario: el “Cristalino”.

Según las descripciones de la época, el nuevo planetario se trataba de “una esfera de metal, cubierta por un cristal, en el cual un zodiaco tenía su propio movimiento”. En el año 1554, Carlos V lo nombra Relojero Real y Turriano se incorpora al servicio del emperador en Bruselas. Allí conocería, entre otros, a Juan de Herrera, y, años más tarde, acompañaría al emperador a su retiro en Yuste, con el que permanecería, hasta su muerte en 1558, encargándose del mantenimiento de sus relojes.

Tras la muerte del emperador pasó al servicio de su hijo, Felipe II. El nuevo monarca no era tan aficionado a los relojes y autómatas como su padre, pero no quiso prescindir de sus servicios, así que lo nombra Matemático Mayor. El italiano asesora a la Corona en numerosas obras de ingeniería (especialmente, hidráulicas), como las del Canal del Jarama, la presa de Colmenar o del embalse de Tibi. Durante este tiempo, además, diseña las campanas de San Lorenzo del Escorial, construye varios molinos y continúa creando nuevos autómatas, algunos tan conocidos como el misterioso “Hombre de palo”.

Escala de Valturio en su “De Re Militari” del 1462. Disponible en googlebooks

Escala de Valturio en su “De Re Militari” del 1462. Disponible en googlebooks Es en 1565 cuando Turriano se instala definitivamente en Toledo. Para aquel entonces, la ciudad ya no es la capital imperial, pues ya hace unos años desde que Felipe II estableció su Corte en Madrid. En los años en los que lo ha sido, Toledo ha vivido una época de esplendor y expansión demográfica, aunque no ha resuelto su problema de suministro de agua que arrastra.

Durante la época romana, el agua llegaba hasta la ciudad gracias a un acueducto-sifón. Un tipo de acueducto que se valía del uso del principio de los vasos comunicantes para reducir su altura. Para ello, el agua no circulaba a cielo abierto, sino que lo hacía por dentro de una cañería. El acueducto, que tenía menos altura que los puntos que unía, estaba compuesto por un primer tramo descendente, seguido de uno llano y, finalmente, otro ascendente para recuperar el nivel. De no haberse construido el tramo llano, la presión a la que se hubiera visto sometida la tubería hubiera sido mucho mayor.

Una vez en la ciudad, el agua se almacenaba en un sistema de depósitos, del que la Cueva de Hércules parece que formaba parte, y del que la gente se abastecía. Sin embargo, después del abandono que sufrió durante la Edad Media, en el siglo XVI apenas quedaban las ruinas del acueducto. La noria gigante que se había construido en tiempos de la dominación musulmana también había desaparecido. Así que Toledo no tenía otra opción que ahogar su sed con los cántaros de agua que se subían a lomos de burros cada día desde el Tajo. Era un método ineficiente y penoso, los animales tenían que superar un desnivel de casi 100 metros cargados con los cántaros.

Varios habían sido los intentos para “modernizar” la situación, pero todos sin éxito. Los sistemas de bombas fracasaron por la enorme presión a la que sometían, y que eran incapaces de aguantar, las tuberías. Para reducir la presión, se pensó en un sistema que superara el desnivel por etapas, aunque la idea tampoco funcionó.

No es de extrañar, entonces, que en una de sus primeras visitas a Toledo, Turriano ya recibiera el desafío por parte de Alfonso de Ávalos, Marqués del Vasto de idear un método más eficiente para llevar el agua hasta la ciudad. El proyecto, sin embargo, parece que quedó aparcado hasta el 1565, cuando la ciudad lo contrató a sugerencia de Felipe II. Después de cerrar un acuerdo con los representantes del monarca y de la ciudad, Turriano se puso manos a la obra a trabajar en su artificio. El ingeniero correría con los gastos de la obra y la ciudad le pagaría cuando estuviera acabada y comprobara que funcionaba. 8.000 ducados del rey y una renta de 1.900 de la ciudad para él y sus sucesores.

En sólo cuatro años, el ingenio estaba listo y suministraba a la ciudad unos 14.100 litros al día, un 50% más de lo comprometido. La primera subida de agua fue el 23 de febrero de 1569. Las autoridades de la ciudad pudieron comprobar lo bien que funcionaba, pero, para sorpresa de Turriano, rehusaron pagar arguyendo que puesto que el agua se almacenaba en el Alcázar era para uso exclusivo del palacio real y no para el de la ciudad.

Frustrado y en una situación económica complicada, Turriano propuso a la ciudad la construcción de un segundo artificio. Esta vez sería él el que retendría los derechos de su explotación. La obra se completó en 1581 y, esta vez, al parecer, Turriano sí que cobró. Aunque su calvario no había acabado. El ingeniero no podía hacer frente a los posteriores costes de mantenimiento del ingenio y tuvo que acabar cediendo su control a la ciudad.

El artificio había causado gran sensación. No sólo dentro de España, donde la mayoría de grandes escritores del Siglo de Oro lo mencionan en sus obras, sino también fuera. Hasta entonces sólo se había conseguido subir agua a menos de la mitad de la altura a la que lo hacía la máquina de Juanelo, unos 40 metros, en Augsburgo (Baviera) usando un tornillo de Arquímedes. Pero pese al éxito y el renombre ganado, Turriano moriría en su casa de Toledo casi en la indigencia el 13 de junio de 1585, poco después de haberse visto obligado a ceder su artificio a la ciudad al no poder hacerse cargo de su mantenimiento. Su cuerpo fue enterrado de caridad en el Convento del Carmen.

Lo poco que quedaba del artificio en 1868. Antes de ser demolido. Fotos originales en Toledo Olvidado

Lo poco que quedaba del artificio en 1868. Antes de ser demolido. Fotos originales en Toledo Olvidado Las máquinas, sin embargo, continuaron funcionando hasta el 1639, aunque cada vez dando un rendimiento menor. Para entonces, por culpa de la falta de mantenimiento y del robo de piezas, las dos máquinas ya estaban en un muy mal estado. Ese año, la primera fue desmantelada y la segunda se dejó en pie como símbolo de la ciudad. Sin los artificios de Juanelo, la situación volvió a la normalidad y el agua volvió a subir a la ciudad a lomos de sus burros. Con el paso del tiempo, poco quedó del segundo. El pillaje lo acabó reduciendo a ruinas también.

Pero pese al paso de los años y la desaparición física de la maquinaría, la admiración por el artificio no se ha perdido, y la respuesta a la pregunta de cómo funcionaba el Artificio de Juanelo todavía sigue siendo motivo de controversia. Han sido varios los que han intentado encontrar una explicación y varios los modelos propuestos, pero no es una tarea fácil, al no haberse conservado ningún plano o dibujo del artificio. Lo único con lo que han podido contar, los que lo han intentado, ha sido con las descripciones efectuadas por los viajeros y escritores de la época.

El primero en enfrentarse al reto fue el ingeniero de minas Luis de la Escosura y Morrogh en 1888. El ayuntamiento de Toledo le había encargado un estudio sobre el problema de abastecimiento de agua de la ciudad, que en esa época aún seguía sin solución. Escosura aprovechó para interesarse por el antiguo artificio e intentó averiguar cómo funcionaba. Escosura partió de lo que había dejado escrito sobre el artificio Ambrosio de Morales, amigo y humanista de Juanelo. Sin embargo, pronto se dio cuenta era demasiado complicado hacerse una idea de su funcionamiento sólo con esa descripción, por lo que decidió buscar la inspiración en alguna ilustración de algún libro de la época.

Al cabo de un tiempo, Escosura creyó encontrar lo que buscaba en una lámina del ingeniero renacentista italiano Agostino Ramelli en la que muestra el diseño de una máquina para elevar agua. Escosura, sin embargo, hizo pequeñas adaptaciones para que la máquina se ajustara mejor con la descripción de Morales. Cambió los cajones y canales por cazos metálicos y caños, y sustituyó la transmisión original de la lámina por una basada en escalas de Valturio, para hacerla encajar mejor con el fragmento de la descripción de Morales: “La suma de [esta invención] es anexar o engoznar unos maderos pequeños en cruz por en medio y por los extremos, de la manera que en Roberto Valturio está una máquina para levantar un hombre en alto”.

Estas escalas, accionadas por el giro de una rueda, se moverían de forma alternativa y proporcionarían a los cazos el movimiento de vaivén que la máquina de Ramelli necesitaba para su funcionamiento. Un cazo primero descendería para recoger el agua del cazo anterior para luego ascender y verterla sobre el cazo que le seguía. De esta manera, de cazo en cazo, el agua iría ganando altura. Para completar el modelo, Escosura le agregó otra noria que movería una cadena o correa con vasijas de agua y que sería la que subiría el agua desde el río hasta la primera de las máquinas.

Durante mucho tiempo, la hipótesis postulada por Escosura en su “El artificio de Juanelo y el Puente de Julio César” fue ampliamente aceptada, hasta que el investigador de la técnica Ladislao Reti, intrigado por la cuestión, decidió investigar más. En seguida, comprobó que existía más descripciones y documentos de la época de que los que Escosura había usado para formular su hipótesis y, en 1967, propuso su propio modelo.

Curiosamente, Reti también se sirvió del mismo libro de Ramelli, “Le diverse et artificiose machine”, para inspirarse, pero reconoció el artificio de Juanelo en una lámina distinta. También se trataba de una máquina que servía para elevar agua gracias a una noria, pero esta vez lo que se hacía oscilar eran los cazos situados en una torre de manera vertical, no sobre un plano inclinado. Según Reti, este sería el verdadero secreto del artificio. Los cazos, o cucharones, de la torre oscilarían de manera que el agua iría pasando de cazo en cazo a través de un caño o tubo hasta subir al depósito superior, desde el cual los cazos de la siguiente torre se encargarían de seguir elevando el agua.

El artificio también estaría compuesto además por dos ruedas hidráulicas. La primera funcionaría como una noria normal y serviría para superar los primeros 14 metros de desnivel. Mientras que la segunda proporcionaría la fuerza motriz para hacer oscilar los torreones de cazos. Con varios de estos torreones el agua superaba finalmente todo el desnivel.

Modelo del artificio completo siguiendo el modelo de cazos oscilantes. Original

Modelo del artificio completo siguiendo el modelo de cazos oscilantes. Original Unos años depués, el estudioso Nicolás García Tapia corrigió algunas de las imprecisiones de este modelo y propuso un nuevo modelo basado en él. El mayor problema del anterior modelo era que las torres contaban con una única vía de agua, cuando en la mayoría de documentos siempre se habla de dos. Tampoco parecía coincidir la apariencia de las torres con la descripción que dio de ellas un viajero inglés, según la cual “…los dos lados de la máquina parecían dos pies que alternativamente pisaban el agua, como los hombres que exprimen las uvas en el lagar cuando la vendimia…”.

Teniendo en mente estos problemas y algunos otros, García Tapia propuso unas modificaciones a la solución de Reti. Las torres de su modelo son, en cierta manera, el resultado de combinar ingeniosamente dos de las de Reti en una sola. De esta manera, las torres tendrían dos vías de agua y una apariencia simétrica, lo que haría que su movimiento bien pudiera recordar al de un hombre saltando alternativamente sobre cada uno de sus pies.

Modelo modificado de García Tapia, ver animación

Modelo modificado de García Tapia, ver animación En la actualidad, la de García Tapia es la hipótesis defendida por la Fundación Juanelo Turriano. Sin embargo, tiene, aparentemente, un defecto: no utiliza las escalas de Valturio de las que habla Ambrosio Morales. Según los que apoyan la teoría, tal problema no existe. Por un lado, Morales bien podría haber confundido la disposición de las tablillas que unen los cazos con una de esas escalas, pues la forma es similar, y, además, la descripción de Morales es un tanto ambigua y no permite concluir con total seguridad si bien se refiere simplemente al modo en que estaban encajadas las tablillas unas con otras o si, en efecto, formaban una escala.

Además, la teoría de Reti-García Tapia se vio reforzada con hallazgo y publicación en la Revista de Estudios Extremeños del casi desconocido “Itinerario hispánico del Chantre de Évora en 1604” . Un relato en el que un canónigo de Évora cuenta su peregrinación de 30 días por el centro de España y que le lleva a visitar Toledo. Como no podía ser de otra manera, allí visita el artificio del que dice estar formado por varias torretas oscilantes de cazos que subían el agua de forma escalonada. El documento además incluye unos esquemas, que aunque son bastante rudimentarios, son los únicos realizados por alguien que viera el artificio en funcionamiento.

Más recientemente, el ingeniero Xavier Jufre (ver entrevista) ha propuesto un nuevo modelo basado totalmente en escalas de Valturio, en este caso verticales. Las diferentes escalas, situadas sobre un plano inclinado, se moverían de forma alternativa hacia arriba y abajo. De manera que cuando una escala se encuentra desplegada del todo, y sus cazos se encuentran en su posición más alta, vierte su agua sobre la siguiente, que se encuentra su posición más baja al estar casi plegada del todo. De esta manera, el agua iría pasando de escala en escala hasta superar todo el desnivel. Las escalas se plegarían y desplegarían mediante un sistema de transmisión accionado por el movimiento de una noria.

El mecanismo según Xavier Jufre Garcia. Original

El mecanismo según Xavier Jufre Garcia. OriginalPS(i): En el 1998 se firmó un contrato para reconstruirlo. PS(ii): El príncipe heredero de Japón, Naruhito, visitó sus ruinas un veraniego día del 2008.

Actualización 7-Septiembre-2010: Entrevista a Xavier Jufre en la que nos explica las bondades de su modelo y otras muchas cosas interesantes

20130214

Rusia se embarca en la construcción de su mayor buque de guerra desde la era soviética

Rusia se embarca en la construcción de su mayor buque de guerra desde la era soviética

La Marina de Guerra rusa ha lanzado su proyecto más ambicioso para la próxima década al aprobar un diseño de destructor de alta mar presentado por el Buró de diseños Sévernoye, en San Petersburgo.

Una vez defendido el concepto del proyecto, en 2-3 años será desarrollada la documentación técnica y el diseño de la nave, y serán definidas las armas que portará, informa este miércoles el diario 'Izvestia' remitiéndose a una fuente anónima de la industria militar rusa. Lo más probable es que el destructor sea armado en los astilleros Severnaya Verf, de San Petersburgo, pero el mando naval supremo todavía no ha tomado una decisión definitiva al respecto, señaló la fuente.

Con un desplazamiento de unas 12.000 toneladas, el nuevo superdestructor será el mayor buque de guerra diseñado y construido desde la época soviética. La última nave de gran desplazamiento fue construida dos años antes de la desaparición de la URSS, en 1989, cuando fue botado el crucero de misiles Piotr Velíki (Pedro el Grande) de propulsión nuclear. En 1998 esta nave se convirtió en el buque insignia de la Flota rusa del Norte y hasta ahora es el buque de guerra más grande (con un desplazamiento máximo de 26.190 toneladas) del mundo, con la excepción de los portaaviones.

"Se supone que el desplazamiento del destructor será igual o poco menor que el proyecto 1164 de cruceros de misiles clase Moskvá [buque insignia de la Flota rusa del mar Negro], es decir, con cerca de 12.000 toneladas. Se trata de una nave universal, capaz de cumplir misiones de ataque, antisubmarinas, antiaéreas e incluso antimisiles. Además, será capaz de brindar un apoyo a las tropas terrestres en las zonas costeras", precisó la fuente de 'Izvestia'.

El superdestructor estará dotado de misiles antibuque, misiles de crucero para ser lanzados contra objetivos en tierra, sistemas de defensa antiaérea y antimisiles, incluyendo el S-500 Prometey. Para combatir los objetivos subacuáticos estará dotado de un potente sonar y de torpedos antisubmarinos.

El único destructor de alta mar de la Armada rusa fue desarrollado en la URSS y pertenece al proyecto 956 clase Sovremenni. Desplaza 8.000 toneladas y está armado sólo con misiles antibuque clase Moskit y sistemas de defensa antiaérea, sin disponer de armas anti-submarino. El destructor requiere un cuidadoso mantenimiento de su planta propulsora, sobre todo respecto a la calidad de agua para sus calderas. Por lo tanto, desde la década de 1990 han quedado operativos solo 9 de estas naves.

"Nuestra Armada necesita un destructor de este tipo desesperadamente y su gran desplazamiento no debe llamar la atención. El principal destructor estadounidense de este tipo, clase Arleigh Burke, tampoco es pequeño: desplaza 9.648 toneladas, porta misiles de crucero Tomahawk y misiles antibuque Harpoon. Los 62 destructores clase Arleigh Burke disponen de defensa antiaérea superpotente, al estar provistos de sistema Aegis", indicó el funcionario.

En primer lugar, el nuevo destructor debería defender a portahelicópteros de clase Mistral, y en el futuro a futuros portaaviones nucleares.

La Marina de Guerra rusa ha lanzado su proyecto más ambicioso para la próxima década al aprobar un diseño de destructor de alta mar presentado por el Buró de diseños Sévernoye, en San Petersburgo.

Una vez defendido el concepto del proyecto, en 2-3 años será desarrollada la documentación técnica y el diseño de la nave, y serán definidas las armas que portará, informa este miércoles el diario 'Izvestia' remitiéndose a una fuente anónima de la industria militar rusa. Lo más probable es que el destructor sea armado en los astilleros Severnaya Verf, de San Petersburgo, pero el mando naval supremo todavía no ha tomado una decisión definitiva al respecto, señaló la fuente.

Con un desplazamiento de unas 12.000 toneladas, el nuevo superdestructor será el mayor buque de guerra diseñado y construido desde la época soviética. La última nave de gran desplazamiento fue construida dos años antes de la desaparición de la URSS, en 1989, cuando fue botado el crucero de misiles Piotr Velíki (Pedro el Grande) de propulsión nuclear. En 1998 esta nave se convirtió en el buque insignia de la Flota rusa del Norte y hasta ahora es el buque de guerra más grande (con un desplazamiento máximo de 26.190 toneladas) del mundo, con la excepción de los portaaviones.

"Se supone que el desplazamiento del destructor será igual o poco menor que el proyecto 1164 de cruceros de misiles clase Moskvá [buque insignia de la Flota rusa del mar Negro], es decir, con cerca de 12.000 toneladas. Se trata de una nave universal, capaz de cumplir misiones de ataque, antisubmarinas, antiaéreas e incluso antimisiles. Además, será capaz de brindar un apoyo a las tropas terrestres en las zonas costeras", precisó la fuente de 'Izvestia'.

El superdestructor estará dotado de misiles antibuque, misiles de crucero para ser lanzados contra objetivos en tierra, sistemas de defensa antiaérea y antimisiles, incluyendo el S-500 Prometey. Para combatir los objetivos subacuáticos estará dotado de un potente sonar y de torpedos antisubmarinos.

El único destructor de alta mar de la Armada rusa fue desarrollado en la URSS y pertenece al proyecto 956 clase Sovremenni. Desplaza 8.000 toneladas y está armado sólo con misiles antibuque clase Moskit y sistemas de defensa antiaérea, sin disponer de armas anti-submarino. El destructor requiere un cuidadoso mantenimiento de su planta propulsora, sobre todo respecto a la calidad de agua para sus calderas. Por lo tanto, desde la década de 1990 han quedado operativos solo 9 de estas naves.

"Nuestra Armada necesita un destructor de este tipo desesperadamente y su gran desplazamiento no debe llamar la atención. El principal destructor estadounidense de este tipo, clase Arleigh Burke, tampoco es pequeño: desplaza 9.648 toneladas, porta misiles de crucero Tomahawk y misiles antibuque Harpoon. Los 62 destructores clase Arleigh Burke disponen de defensa antiaérea superpotente, al estar provistos de sistema Aegis", indicó el funcionario.

En primer lugar, el nuevo destructor debería defender a portahelicópteros de clase Mistral, y en el futuro a futuros portaaviones nucleares.

20130213

El Curiosity encuentra un extraño objeto metálico en una roca en Marte

El Curiosity encuentra un extraño objeto metálico en una roca en Marte

La NASA ha explicado que puede estar hecho de un material que se encuentra en el interior de las rocas y que es más resistente a la erosión

El rover Curiosity de la NASA ha fotografiado una segunda protuberancia de aspecto metálico en una roca de la superficie marciana. Según ha explicado la NASA, podría estar hecha de un material que se encuentra en el interior de las rocas y que es más resistente a la erosión. También se baraja la posibilidad (aunque menos probable) de que podría ser algo que está "creciendo" en la roca.

Se trata de la segunda vez que el vehículo capta un objeto de estas características. El pasado mes de octubre se halló la conocida como 'flor' de Marte, que en un principio se pensó que era una pieza de plástico que se había desprendido del rover, aunque aún no se ha hecho público ningún resultado acerca de su origen. Un mes antes, el rover se detenía a analizar una roca en forma de pirámide, que la NASA consideró una "roca perfecta". Ni uno, ni otro finalmente "cambió los libros de historia".

Según los expertos, una de las características que les lleva a pensar que se trata de un objeto metálico es que no está cubierto por el polvo, como el resto de la superficie, a pesar de su pequeño tamaño (aproximadamente 0,5 centímetros de altura). "Las superficies metálicas tienen a limpiarse fácilmente", según ha señalado la agencia espacial estadounidense, cuyos primero experimentos sobre superficie marciana concluyeron que se parece a Hawái.

Desde la NASA han asegurado que el estudio de este objeto, que fue hallado el 30 pasado de enero, continuará con el fin de "obtener más detalles" acerca de su origen. "Sea lo que sea es interesante", ha apuntado uno de los miembros de la misión Curiosity.

La NASA ha explicado que puede estar hecho de un material que se encuentra en el interior de las rocas y que es más resistente a la erosión

El rover Curiosity de la NASA ha fotografiado una segunda protuberancia de aspecto metálico en una roca de la superficie marciana. Según ha explicado la NASA, podría estar hecha de un material que se encuentra en el interior de las rocas y que es más resistente a la erosión. También se baraja la posibilidad (aunque menos probable) de que podría ser algo que está "creciendo" en la roca.

Se trata de la segunda vez que el vehículo capta un objeto de estas características. El pasado mes de octubre se halló la conocida como 'flor' de Marte, que en un principio se pensó que era una pieza de plástico que se había desprendido del rover, aunque aún no se ha hecho público ningún resultado acerca de su origen. Un mes antes, el rover se detenía a analizar una roca en forma de pirámide, que la NASA consideró una "roca perfecta". Ni uno, ni otro finalmente "cambió los libros de historia".

Según los expertos, una de las características que les lleva a pensar que se trata de un objeto metálico es que no está cubierto por el polvo, como el resto de la superficie, a pesar de su pequeño tamaño (aproximadamente 0,5 centímetros de altura). "Las superficies metálicas tienen a limpiarse fácilmente", según ha señalado la agencia espacial estadounidense, cuyos primero experimentos sobre superficie marciana concluyeron que se parece a Hawái.

Desde la NASA han asegurado que el estudio de este objeto, que fue hallado el 30 pasado de enero, continuará con el fin de "obtener más detalles" acerca de su origen. "Sea lo que sea es interesante", ha apuntado uno de los miembros de la misión Curiosity.

20130212

Cómo hacer un Calentador Solar en casa con botellas PET

Cómo hacer un Calentador Solar en casa con botellas PET

Hace ocho años José Alano, un mécanico brasileño retirado, tuvo la inspiración de recoger botellas de plástico (PET) y cartones de leche usados para desarrollar un sistema de calentamiento de agua por energía solar simple, barato y que pudiera construir cualquier persona.

The Ecologist le dedica un estupendo artículo contando su historia:

…viendo que en su pequeño pueblo de Tubarão no existía ninguna infraestructura para reciclar los envases y sintiéndose incapaces de tirar todos esos envases a la basura, Alano y su mujer pronto se encontraron con una habitación llena de botellas y cartones de leche vacíos. [...] Haciendo uso de su ingenio y experiencia con captadores solares, él y su esposa construyeron una versión alternativa utilizando 100 botellas PET y 100 cartones de leche usados. El prototipo funcionó a la perfección, al tiempo que dieron una nueva vida a todos esos desperdicios de manera responsable.

Desde la invención de este calefactor solar allá por 2002, Alano no ha dejado de difundir esta idea en Brasil por medio de conferencias y talleres en comunidades de vecinos y colegios. Entidades locales, medios de comunicación y hasta compañías eléctricas han colaborado en la difusión de esta magnífica práctica. Las cifras exactas no se conocen, aunque Alano menciona algunas:

Más de 7.000 personas se están beneficiando ya de estos captadores auto construidos (DIY) sólo en el estado de Santa Catarina. Ya existen dos cooperativas, una en Tubarão y otra en Florianópolis, la última de las cuales ha producido 437 captadores que se instalarán en ayuntamientos. En el estado de Paraná, el número de captadores instalados en 2008 fue de 6.000, gracias a los talleres y a los folletos distribuidos entre la población.

Adjuntamos varias imágenes del proceso de fabricación.

Hace ocho años José Alano, un mécanico brasileño retirado, tuvo la inspiración de recoger botellas de plástico (PET) y cartones de leche usados para desarrollar un sistema de calentamiento de agua por energía solar simple, barato y que pudiera construir cualquier persona.

The Ecologist le dedica un estupendo artículo contando su historia:

…viendo que en su pequeño pueblo de Tubarão no existía ninguna infraestructura para reciclar los envases y sintiéndose incapaces de tirar todos esos envases a la basura, Alano y su mujer pronto se encontraron con una habitación llena de botellas y cartones de leche vacíos. [...] Haciendo uso de su ingenio y experiencia con captadores solares, él y su esposa construyeron una versión alternativa utilizando 100 botellas PET y 100 cartones de leche usados. El prototipo funcionó a la perfección, al tiempo que dieron una nueva vida a todos esos desperdicios de manera responsable.

Desde la invención de este calefactor solar allá por 2002, Alano no ha dejado de difundir esta idea en Brasil por medio de conferencias y talleres en comunidades de vecinos y colegios. Entidades locales, medios de comunicación y hasta compañías eléctricas han colaborado en la difusión de esta magnífica práctica. Las cifras exactas no se conocen, aunque Alano menciona algunas:

Más de 7.000 personas se están beneficiando ya de estos captadores auto construidos (DIY) sólo en el estado de Santa Catarina. Ya existen dos cooperativas, una en Tubarão y otra en Florianópolis, la última de las cuales ha producido 437 captadores que se instalarán en ayuntamientos. En el estado de Paraná, el número de captadores instalados en 2008 fue de 6.000, gracias a los talleres y a los folletos distribuidos entre la población.

Adjuntamos varias imágenes del proceso de fabricación.

20130211

Una batería creada por Edison hace un siglo vuelve a estar de actualidad y a competir con las de Litio

Una batería creada por Edison hace un siglo vuelve a estar de actualidad y a competir con las de Litio

El CEO, Brandon Williams, comenta que

han creado su negocio con el fin de servir las necesidades de

almacenamiento energético de los propietarios de edificios, centros de

datos, instalaciones aisladas y clientes que se preocupan tanto por su

impacto ambiental, o por tener un respaldo fiable en caso de corte de

fluido eléctrico.

Las baterías de Níquel-Hierro (Ni-Fe) –

desarrolladas hace más de un siglo por Thomas Edison – están

reemplazando gradualmente a las baterías de plomo en una serie de

aplicaciones, especialmente para energía solar fotovoltaica

y renovables. A diferencia de las baterías de plomo-ácido, son de alta

fiabilidad , con una vida útil más larga y la operación libre de

toxicidad.

Cita una reacción de carga/descarga perfecta, como razón principal para su máximo rendimiento. En cuanto a las comparaciones de precios y el rendimiento, la batería de Ni-Fe es más cara que una batería de plomo-ácido, sin embargo ofrece una descarga tres veces más profunda sin consecuencias, además de que dura mucho más tiempo, dice Williams.

En cuanto a la batería de iones de litio, Williams opina que es excelente para los vehículos eléctricos ybicicletas, pero que no está lista para las grandes aplicaciones de almacenamiento estacionario, aunque cree que la tecnología Li-ion está progresando mucho últimamente.

Para las baterías de plomo-ácido en todo el mundo, está la cuestión del daño que la composición química del electrolito puede causar al medio ambiente. Las baterías de níquel-hierro no usan metales tóxicos como el plomo y el cadmio. El níquel no es tampoco lo que se dice inocuo, pero es mucho menos tóxicos. ”Los beneficios ambientales reales se reducen al hecho de que no tenemos que sustituir una batería de níquel-hierro, sino que sólo tenemos que actualizar el electrolito líquido cada 7-10 años”, todo un gran avance en cuanto a sostenibilidad.

Williams señala que, en los países en desarrollo donde no hay importantes esfuerzos de reciclaje, las baterías de plomo representan un peligro ambiental grave. El número de baterías de plomo que se utilizan en China para las bicicletas eléctricas y coches, por ejemplo, es enorme. Sin embargo, la mayoría de ellas no se reciclan, y son a menudo simplemente tirabas a la basura, donde se puede lixiviar los contenidos tóxicos en las capas freáticas.

Bienvenidos a una tecnología antigua en una nueva era.

Vía Clean Technica

La compañía estadounidense, afincada en Colorado, Iron Edison Battery Company,

ha presentado una tecnología de baterías que, aunque siendo poco

novedosa, ya que fue una tecnología descubierta y desarrollada por el

mismísimo Edison, sí retorna a la actualidad con fuerza renovada.

Los últimos desarrollos de esta olvidada

tecnología llevados a cabo por la compañía , tras decadas en el olvido,

han conseguido alumbrar una alternativa competitiva al predominio de

las baterías basadas en tecnología de Litio. Su mayor ventaja frente a las baterías de Litio: su baja toxicidad.

“Hemos visto millones de baterías estaban siendo tiradas a la basura cada año, y nos dedicamos a investigar cómo tomar medidas para resolver este problema”, dice Williams.

“La tecnología de níquel-hierro es grande, porque es como volver a descubrir este gran invento”, añade Williams. ”El hecho de que Thomas Edison desarrollara esta tecnología hace que la historia sea aún más emocionante.”Modernas baterías de Ni-Fe se utilizan principalmente para aplicaciones estacionarias y por lo general duran más que sus homólogas de plomo-ácido. Williams dice que espera que sus baterías duren 20 años o más en operación contínua, y agregó que tiene conocimiento de algunas baterías de Ni´Fe con más de 50 años de edad que todavía están funcionando bien.

Cita una reacción de carga/descarga perfecta, como razón principal para su máximo rendimiento. En cuanto a las comparaciones de precios y el rendimiento, la batería de Ni-Fe es más cara que una batería de plomo-ácido, sin embargo ofrece una descarga tres veces más profunda sin consecuencias, además de que dura mucho más tiempo, dice Williams.

“En una batería de plomo-ácido, las placas de plomo sólido se disuelven en el electrolito líquido durante la descarga”, dice Williams. ”Cuando se recarga una batería de plomo, no todo el sólido es capaz de salir de la solución y unirse quimicamente de nuevo a las placas, sufriendo una reacción incompleta que va deteriorando la batería”

En cuanto a la batería de iones de litio, Williams opina que es excelente para los vehículos eléctricos ybicicletas, pero que no está lista para las grandes aplicaciones de almacenamiento estacionario, aunque cree que la tecnología Li-ion está progresando mucho últimamente.

Para las baterías de plomo-ácido en todo el mundo, está la cuestión del daño que la composición química del electrolito puede causar al medio ambiente. Las baterías de níquel-hierro no usan metales tóxicos como el plomo y el cadmio. El níquel no es tampoco lo que se dice inocuo, pero es mucho menos tóxicos. ”Los beneficios ambientales reales se reducen al hecho de que no tenemos que sustituir una batería de níquel-hierro, sino que sólo tenemos que actualizar el electrolito líquido cada 7-10 años”, todo un gran avance en cuanto a sostenibilidad.

Williams señala que, en los países en desarrollo donde no hay importantes esfuerzos de reciclaje, las baterías de plomo representan un peligro ambiental grave. El número de baterías de plomo que se utilizan en China para las bicicletas eléctricas y coches, por ejemplo, es enorme. Sin embargo, la mayoría de ellas no se reciclan, y son a menudo simplemente tirabas a la basura, donde se puede lixiviar los contenidos tóxicos en las capas freáticas.

Bienvenidos a una tecnología antigua en una nueva era.

Vía Clean Technica

20130210

Centrales reversibles

https://demanda.ree.es/generacion_acumulada.html

con cosas así se podría reducir la dependencia del petróleo.. pero que cada uno se fabrique parte de la electricidad no conviene a los del "déficit de tarifa"..

20130209

Las diez personas vivas más inteligentes del mundo

Las diez personas vivas más inteligentes del mundo

La organización estadounidense Super Scholar ha elaborado un ranking con las diez personas vivas más inteligentes del mundo. En ella aparece Stephen Hawking, el conocido físico teórico, con un cociente intelectual de 160, 14 premios y 70 años de edad (y experiencia). Según afirman los autores de la lista, con los 7 libros que ha publicado hasta la fecha “ha conseguido que los simples mortales entendamos el universo”.

Otro de los escogidos para este peculiar “top ten” es el ex niño prodigio Kim Ung-Yong, que con un cociente intelectual (CI) de 210 aparece en el Libro Guinness de los Récord y que a los dos años de edad ya hablaba cuatro idiomas; además de que empezó a estudiar en la NASA cuando acababa de cumplir ocho.

También muy populares son otros personajes de la clasificación como Garry Kasparov, el con 190 de cociente intelectual y ganador del título mundial de ajedrez a la edad de 22 años; el matemático británico Andrew Wiles, que demostró el último Teorema de Fermat, considerado “el más difícil del mundo”; y por supuesto Paul Allen, cofundador de Microsoft, que ha sabido utilizar su inteligencia (su CI es de 170) para hacer dinero y figura también en la lista de las 48 personas más ricas del mundo.

Completan la lista el actor James Woods (CI, 180), que antes de entrar en Hollywood estudiaba Álgebra Lineal y fue alumno del prestigioso instituto MIT; el físico Cristopher Hirata (CI, 225), que a los 14 años trabajaba en Caltech; el investigador Terrence Tao (CI, 230),con más de 200 artículos publicados; la niña prodigio del ajedrez Judit Polgar (CI, 170); y el guionista televisivo Rick Rosner (CI, 192).

La organización estadounidense Super Scholar ha elaborado un ranking con las diez personas vivas más inteligentes del mundo. En ella aparece Stephen Hawking, el conocido físico teórico, con un cociente intelectual de 160, 14 premios y 70 años de edad (y experiencia). Según afirman los autores de la lista, con los 7 libros que ha publicado hasta la fecha “ha conseguido que los simples mortales entendamos el universo”.

Otro de los escogidos para este peculiar “top ten” es el ex niño prodigio Kim Ung-Yong, que con un cociente intelectual (CI) de 210 aparece en el Libro Guinness de los Récord y que a los dos años de edad ya hablaba cuatro idiomas; además de que empezó a estudiar en la NASA cuando acababa de cumplir ocho.

También muy populares son otros personajes de la clasificación como Garry Kasparov, el con 190 de cociente intelectual y ganador del título mundial de ajedrez a la edad de 22 años; el matemático británico Andrew Wiles, que demostró el último Teorema de Fermat, considerado “el más difícil del mundo”; y por supuesto Paul Allen, cofundador de Microsoft, que ha sabido utilizar su inteligencia (su CI es de 170) para hacer dinero y figura también en la lista de las 48 personas más ricas del mundo.

Completan la lista el actor James Woods (CI, 180), que antes de entrar en Hollywood estudiaba Álgebra Lineal y fue alumno del prestigioso instituto MIT; el físico Cristopher Hirata (CI, 225), que a los 14 años trabajaba en Caltech; el investigador Terrence Tao (CI, 230),con más de 200 artículos publicados; la niña prodigio del ajedrez Judit Polgar (CI, 170); y el guionista televisivo Rick Rosner (CI, 192).

20130208

La crisis con Amazon AWS

La crisis con Amazon AWS

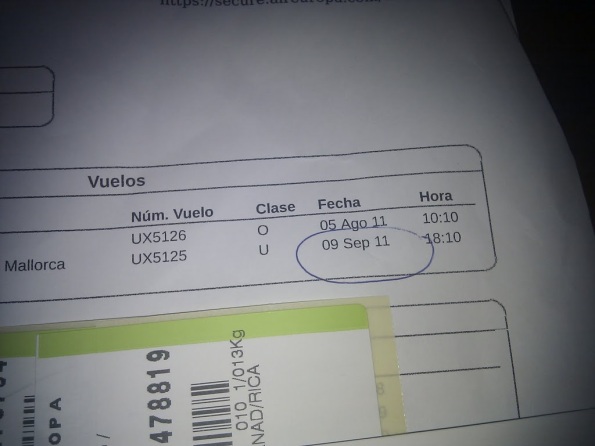

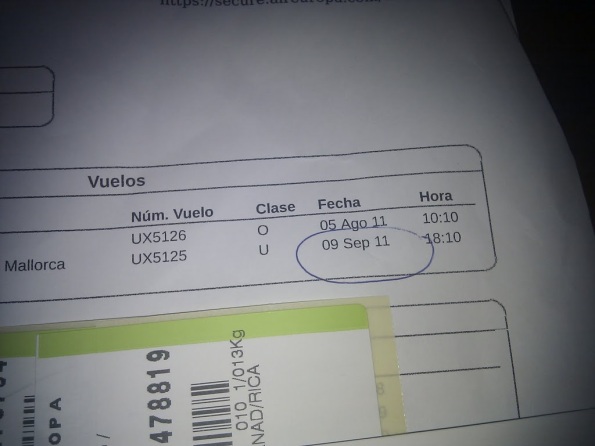

El viernes 5 de agosto me voy con toda la familia a un pueblo de Extremadura cerca de la frontera con Portugal (Valencia de Alcántara) a visitar a unos amigos. Regresábamos el martes 9 a la tarde, ¿qué podía pasar en Menéame que no se pudiese solucionar con una navegador y la consola web de AWS si nunca habíamos tenido problemas graves? Si necesitaba algo más, podía instalar las herramientas de AWS en otro ordenador y solucionarlo en pocos minutos. Así que por primera vez viajo sin mi portátil, sólo mi tablet Android con conexión 3G Vodafone (además de mi teléfono también con 3G).

Pues ocurrió el desastre en Amazon, les falló todo lo que podía fallar, todos nuestros planes de contingencia no podía aplicarse (salvo el “rehacer desde cero” con los bakups) y yo sin mi portátil y con el 3G completamente inestable, prácticamente como si no tuviese conexión. Si no hubiese sido así Menéame no habría estado “off line” tanto tiempo, quizás sólo unas pocas horas. Fue una pesadilla.

Amazon tuvo varios fallos: primero el corte completo de la conectividad a todas las instancias, luego la desincronización del API de gestión, luego los EBS que quedaron totalmente inaccesibles y bloqueando la gestión de las instancias que los usaban, y para rematar un fallo en el software de creación de los “snapshots” (backups por bloques en S3) que borraba datos de algunos bloques (lo descubrieron durante la crisis, y nos afectó a nosotros).

Nota: es un relato rápido, ya corregiré erratas, ahora me voy a duchar, que la última vez fue en Valencia de Alcántara

Pero lo que no se nos había ocurrido era que fallasen todos los EBS al mismo tiempo, y que los “snapshots” también estuviesen corruptos. No sé si es estupidez o no, pero prometo que no se me pasó por la cabeza, mucho menos que ocurriese mientras yo estuviese en un pueblo casi aislado, sin casi conexión a Internet, ni mi portátil con todas las herramientas. Lo pasé fatal.

Durante toda la cena iba probando conectarme desde el móvil. Como a la 1 de la mañana, estando bebiendo unos gintonics en el castillo (@bufetameida y @pixspain en Twitter pueden ratificar lo que cuento, fueron testigos de primera mano) logro entrar por ssh a ambos servidores, aws0 y awsb. El segundo (el máster de la base de datos) estaba perfecto, la base de datos intacta, pero el kernel de aws0 daba errores graves de acceso a los EBS. Tampoco había conectividad entre ellos (ni con ping).

Volvemos a la casa del pueblo (de Carlos Almeida), me conecto con el tablet. La conexión variaba de GPRS a 3G y HDSPA cada pocos segundos, por lo que la conexión ssh era una pesadilla. Intento arreglarlo desmontando los EBS, pero el umount se quedaba bloqueado, es decir, el fallo era muy importante, no había “comunicación” con esos dispositivos.

Hago un reboot de aws0, el reboot se bloquea en mitad del proceso según se veía en la consola web de Amazon AWS. No importa, pienso, tenía un “snapshot” con su AMI correspondiente (para poder arrancar una instancia idéntica directamente) de hacía pocos meses (el 1 de marzo). Desde la consola web hago que arranque una nueva instancia, me da error del snapshot. ¡Mierda! lo que me faltaba, pensé, había hecho algo mal durante la creación del AMI. Al día siguiente nos avisarían que había sido otro problema: